Briefing 274: Der KI-Boom und seine physischen Grenzen 18 Oct 2:18 AM (2 days ago)

Heute wagen wir einen Makro-Blick auf KI, das große Nachfrage sieht, sich aber immer deutlicher einigen Nadelöhren außerhalb der eigentlichen Technologie gegenüber sieht, die am Ende vielleicht zu eng sind für die Erwartungen an die Technologie.

Besonders der China-Aspekt unten könnte sehr wichtig werden. Wie wir bereits neulich im Briefing besprochen hatten: Man kann wichtige Wirtschaftszweige wie KI heute nicht mehr ohne Geopolitik denken.

Nächste Woche wird es kein Briefing geben. Das nächste Briefing erscheint übernächste Woche.

Marcel

Im Fokus der Ausgabe:

OpenAIs Billionen-Wette stößt an physische Grenzen: Das explosive Wachstum von KI trifft auf reale Nadelöhre wie Energiebedarf und Infrastruktur.

China nutzt den Hebel der seltenen Erden: Peking setzt seine Dominanz bei kritischen Rohstoffen als Waffe im Wirtschaftskrieg ein, um auch die westliche Chip-Produktion und den KI-Sektor zu treffen. (und über Bande damit die gesamte US-Wirtschaft)

Deutschlands KI-Infrastruktur fällt zurück: Ein neuer Report zeigt, dass Deutschland bei der KI-Rechenkapazität international den Anschluss zu verlieren droht.

Neue Player, neue Märkte: Während in den USA Robotik-Startups durchstarten, drängen chinesische Tech-Firmen mit selbstfahrenden Autos aggressiv auf den europäischen Markt.

Außerdem: Walmart bei ChatGPT, Social bei Sora, mehr Unternehmen bauen humanoide Roboter und mehr

Zitat des Tages

the choice isnt between "code written by ai" and "artisan handwritten code written by john carmack"

the choice is between "code written by ai" and "something that could have existed, but didnt"

Thema der Woche

Blasen, Wetten, Grenzen & Kapazitäten: OpenAIs Fünfjahres-Geschäftsplan, um die Ausgabenversprechen in Höhe von 1 Billion Dollar zu erfüllen

Parallel zum Best-Case-Szenario für OpenAI, über das wir hier letzte Woche gesprochen haben, hat die Financial Times über die Pläne und den Stand bei OpenAI geschrieben.

Die Fakten:

- OpenAI plant neue Einnahmequellen und Finanzierungsmodelle, um über $1 Bio. an Verpflichtungen zu stemmen.

- Ziel: maßgeschneiderte Produkte für Firmen und Regierungen, Shopping-Tools, Video-Service Sora, AI‑Agenten und Hardware.

- Verpflichtung: >26 GW Kapazität von Oracle, Nvidia, AMD, Broadcom mit Kosten über $1 Bio. in 10 Jahren. (Analysten: 20 GW entspricht ~20 Atomreaktoren an Strombedarf.)

- Aktuell ~$13 Mrd. ARR, 800 Mio. Nutzer, 5% zahlend; OpenAI will Zahl der Abonnenten verdoppeln.

- Hohes Defizit: H1‑Betriebsverlust ~ $8 Mrd.; Infrastruktur bislang von Partnern vorfinanziert; OpenAI setzt auf fallende Kosten und weitere Kapitalrunden.

Anmerkungen:

Zuerst: ChatGPT wird erst Ende November drei Jahre alt und liegt bereits bei 13 Milliarden $ jährliche wiederkehrende Einnahmen. Zum Vergleich: Zalando, das einzige Startup der letzten 2 Jahrzehnte, das zu einem deutschen, börsennotierten Konzern herangewachsen ist, hat für 2025 die Prognose herausgegeben, auf einen Umsatz von 12,1 bis 12,4 Milliarden Euro zu kommen. (Handelsbatt) Das erreichen sie im 17. Jahr ihres Bestehens.

Gleichzeitig wachsen OpenAI und Anthropic (und sicher auch andere wie Together.ai) rasant weiter und haben „nur“ ein Kapazitätsproblem, kein Nachfrageproblem.

Reuters reports that the company is on track to hit $9 billion in annualized revenue this year and projects as much as$26 billion annualized revenue next year. (It was at $1 billion in ARR in January.)

1 Milliarde $ ARR letztes Jahr, dieses Jahr 9 Milliarden $ und nächstes Jahr 26 Milliarden $ ARR. Dauert nicht mehr lang, und wir reden hier über ein richtiges Geschäft.

Neben dem irrsinnigen Umsatzwachstum ist auch die schiere Nutzungsgröße etwas, das vielen in den breiteren Debatten gar nicht deutlich zu sein scheint. Noch vor dem dritten Geburtstag hat ChatGPT 800 Millionen wöchentlich aktive Nutzer:innen erreicht. Facebook hat ein Vielfaches dieser Zeit gebraucht. Preisfrage: Wer gehört zu den größten Werbeplattformen der Welt? Richtig, Meta mit Facebook und Insta. Follow-Up-Frage: Könnte ChatGPT neben dem Abo-Modell zusätzlich ein vergleichbar florierendes Werbemodell etablieren? Follow-Up-Frage: Wo hören die Einnahmequellen auf, wenn man Leute dazu bewegen kann, für ein Abo zu zahlen, Nutzungszahlen und -art wie Facebook und Google aufbaut (Werbung), eigene Gadgets baut (Apple) und mit E-Commerce-Integration auch auf Konfrontationskurs mit Amazon geht (Gebühren von Händlern)? Follow-Up-Frage: Gonna be a man, ask her out?

Vor diesem Hintergrund muss man die massiven Investitionen sehen. Diese Investitionen und Vereinbarungen, eingefädelt vom Deal-King Altman, sind natürlich per Definition Wetten. Weil niemand weiß, wo die Reise hingehen wird. Aber aktuell sieht es aufgrund der auf sie von allen Seiten einprasselnden Nachfrage noch nach geringem Risiko aus.

Geringes Risiko, wenn man nur auf die Nachfrage schaut, die nur von Rechenkapazität, Chipeffizienz und Energiekosten beschränkt wird.

Anders sieht es aus, wenn man auf eben diese Schranken schaut.

Greg Brockman, the company’s president, last week said recent spending commitments would pay for themselves: “If we had 10 [times] more compute [computing power], I don’t know if we’d have 10 [times] more revenue, but I don’t think we would be that far.”

Es dürfte kaum noch einen erwachsenen Menschen im Westen geben, der/die nicht weiß, was ChatGPT ist. Diese enorme Markenwahrnehmung geht einher mit der enormen Nützlichkeit der Technologie. Für Anthropic und Co. arbeitet auch letzteres, aber ihnen fehlt ersteres (die populäre Marke).

Aber kommen wir zu den Grenzen:

These ambitious plans will need to become reality if OpenAI is to meet its liabilities, as the group has made funding commitments that dwarf its income. In the past month, chief executive Sam Altman has committed to take more than 26 gigawatts of capacity from Oracle, Nvidia, AMD and Broadcom, at a rough cost of well over $1tn over the next decade, according to FT calculations. [...]

The company’s deals with AMD and Nvidia are staggered so OpenAI will pay as new capacity is developed. But 20GW of capacity would require power roughly equivalent to that provided by 20 nuclear reactors, and analysts have questioned whether it is realistic for that demand to be met by a single company.

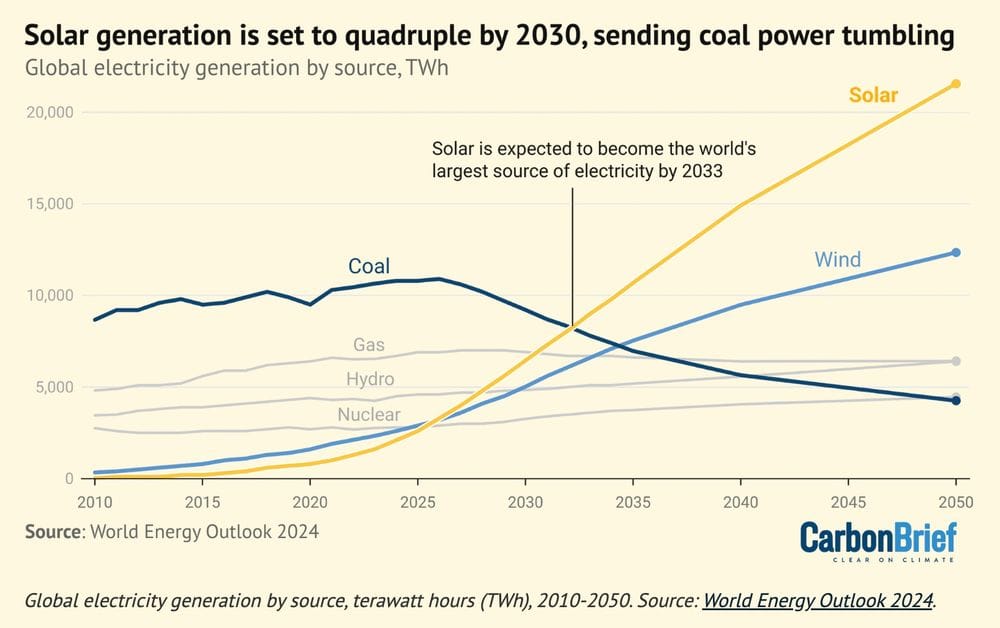

Wo soll's herkommen? Vor allem kurzfristig? Innerhalb der nächsten 3 Jahre? Selbst wenn kleinere modulare Atomkraftwerke regulatorisch einfacher genemigt und damit zu bauen werden, wird Energiezubau länger dauern. Wer hält es für realistisch, dass im gesamten Westen in den nächsten 10 Jahren pro Jahr 2 neue Kernkraftwerke gebaut werden?

Das heißt: Die Obergrenze für KI-Nutzung liegt neben der steigenden Effizienz der High-Tech-Chips (die Energiebedarf senken kann) auch beim Zubau von Energie. Neben, wie wir hier bereits mehrfach diskutiert haben, den organisatorischen Herausforderungen. (Prozessveränderungen sind systemische Herausforderungen, die internen Widerstand überwinden müssen.)

Und: Ein nicht geringer Teil der künftigen Infrastruktur wird außerhalb des Westens liegen. (Ein Effekt zweiter Ordnung könnte sein, dass nicht nur das Training sondern auch die Inferenz, also die Nutzung, von KI außerhalb des Westens in Ländern wie China günstiger sein wird. Zusätzlich zu allem, was man so mit Strom anstellen kann.)

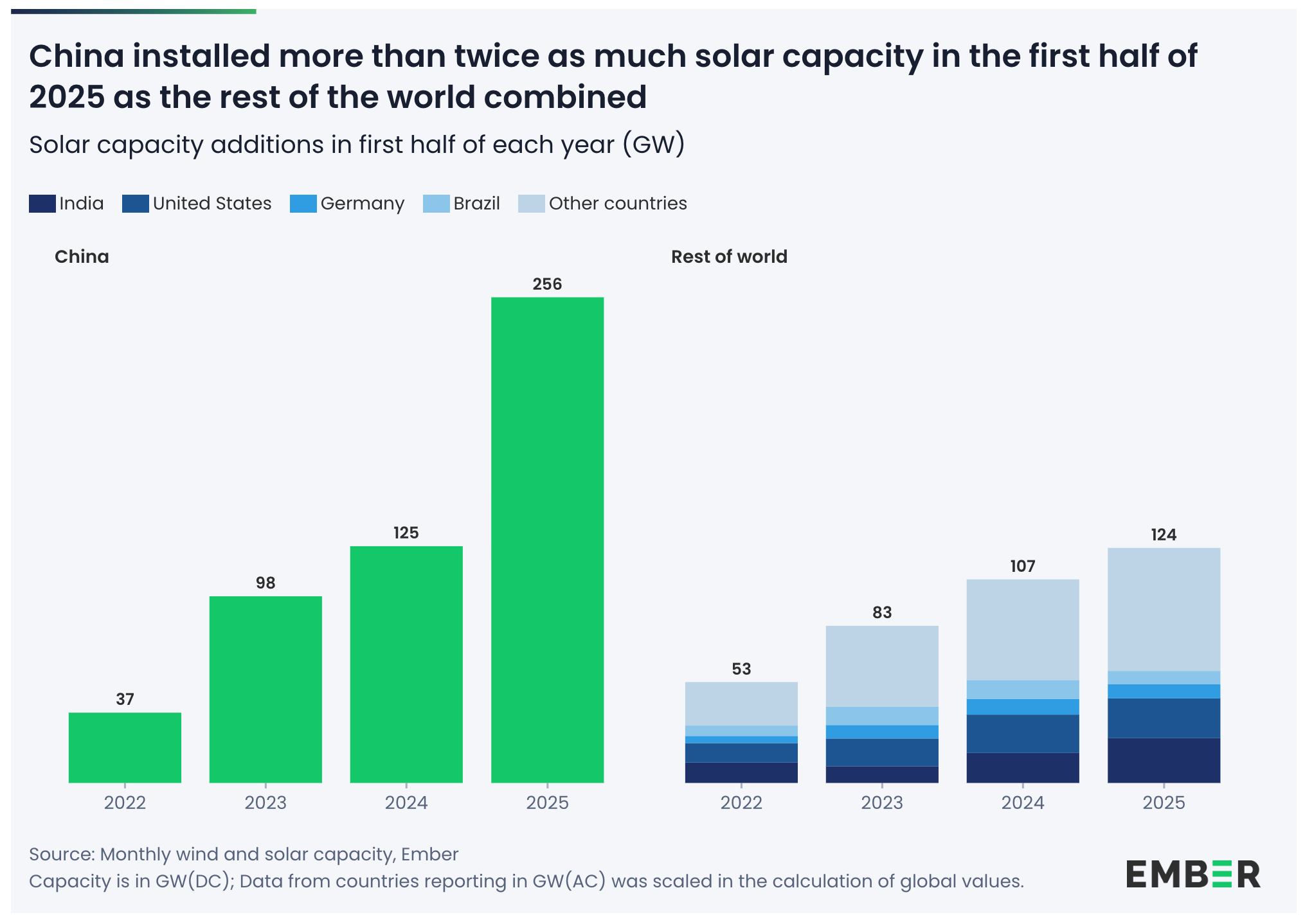

Länder wie China oder Bhutan werden globale Gewinner aufgrund ihrer Energiestrategie. China baut im Jahr zweimal so viel Solarkapazität auf, wie die USA insgesamt bis heute gebaut haben. Oder auch: zwei Mal so viel wie der Rest der Welt zusammen im selben Zeitraum:

China bereitet außerdem vor, den nächsten größten Staudamm der Welt in Betrieb zu nehmen. Der Drei-Schluchten-Damm in China kommt allein bereits auf 22,5 GW. Das nächste Staudamm-Projekt in China soll sogar auf 300 TWh Strom pro Jahr kommen. Bhutan ist ein kleines Land nördlich von Indien, das dank seiner geografischen Lage ebenfalls günstige Wasserkraftwerke bauen kann und explizit für KI aufbauen will. (Economist)

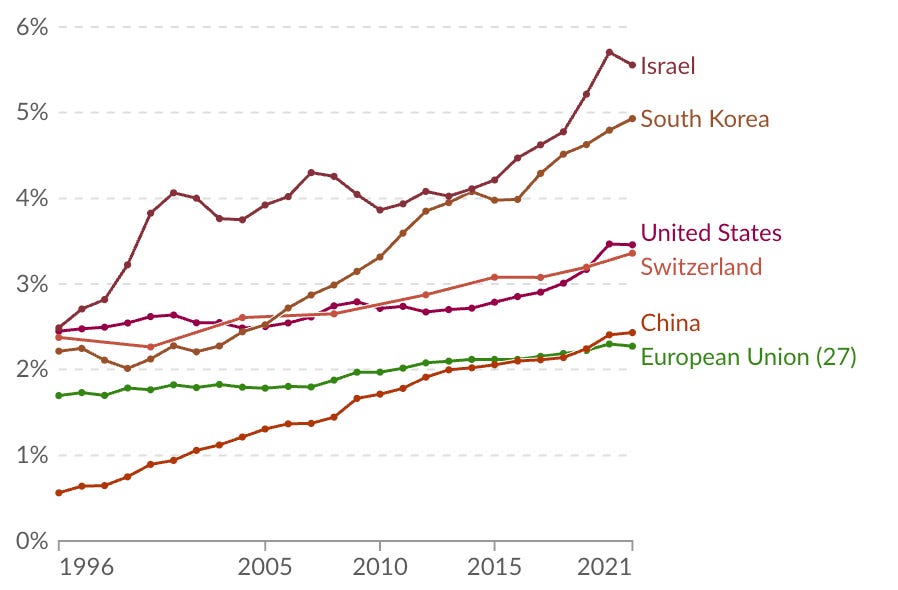

Deshalb rede ich seit langem davon, dass wir insgesamt von KI-Infrastruktur reden müssen, was nicht nur KI-Modelle, sondern eben auch Chips und Strom einschließt. Dieser Text von mir dazu in der FAZ ist bereits ein Jahr alt:

Wer steigende Nutzung und wachsende Ansprüche für das Training neuer KI-Modelle extrapoliert, entdeckt schnell mehr und mehr Engstellen. Heute sind die knappen KI-Chips der bedeutendste Flaschenhals. Der nächste ist der wachsende Strombedarf. Wenn KI wirklich transformativ für die gesamte Wirtschaft ist, dann müssen wir die Anforderungen an ihre Infrastruktur sehr viel ernster nehmen.

Passiert ist dazu in Europa in diesem Jahr nichts Nennenswertes.

But wait, there is more. OpenAI und Nvidia wollen beide auf die jeweils eigene Art (und teils gemeinsam) mit ihren zirkulären Deals parallele Investitionen anschieben, um vom gesamten Ökosystem möglichst viele Beschränkungen zu entfernen:

Two-thirds of the cost of developing new computing power goes towards semiconductors. OpenAI is aiming to stimulate the nascent chip financing market by offering enormous demand, and by forging novel contracts, such as its Nvidia and AMD deals.

Für Nvidia ist das sinnvoll: Was hat Nvidia davon, wenn sie liquides Kapital auf die hohe Kante legen, während ihre Abnehmer und deren Kunden langsamer wachsen, als es möglich wäre? Für OpenAI ist das auch sinnvoll: OpenAI schafft Nachfrage im Ökosystem (etwa für spezifische KI-Chips), so dass die Komponenten schneller für sie verfügbar werden und das gesamte Umfeld grundsätzlich mehr von ihren Produkten konsumieren kann.

Gleichzeitig merkte Ben Thompson diese Woche in seinem Sharptech-Podcast einen wichtigen Aspekt an. Indem OpenAI große Deals mit Nvidia, AMD, Oracle, Softbank und Co. eingeht, binden sie diese Unternehmen auch an das Schicksal von OpenAI. Das verschafft OpenAI langfristig zumindest ein Sicherheitspölsterchen, wenn’s an anderer Stelle mal knapp wird mit dem Kapital. (Da blinzelt er uns wieder an, der kleine Machiavelli namens Sam.)

Die Sinnhaftigkeit bei beiden Unternehmen ändert aber nichts daran, dass zirkuläre Deals (ich investiere in dich, damit du unter anderem mehr von meinen Produkten kaufen kannst) ein Symptom von Spekulationsblasen sind. Ein anderes Symptom sind Investitionen, die über Kredit finanziert werden. Die ersten drei Jahre des KI-Booms wurden finanziert von VC und vom Cashflow der Tech-Riesen. Jetzt gehen wir zur Krediten über. Namentlich vor allem bei Oracle.

Aber worauf ich eigentlich hinaus wollte: Seltene Erden.

Seltene Erden: Der Wirtschaftskrieg erreicht KI

Briefing 273: ChatGPT = Apple-Appstore + Google-Suche + WeChat-Superapp 10 Oct 7:52 AM (10 days ago)

Ich werde die Tage noch etwas über Sora und Vibes schreiben, möchte aber bereits diese neue Bezeichnung in die Runde werfen: User Prompted Content.

Marcel

Im Fokus dieser Ausgabe:

- ChatGPT: Das neue Monster

- Figure 03 und die Skaleneffekte für humanoide Robotik

- KI-Browser Dia und Comet frei verfügbar; eine kurze Einordnung der KI-Implementierung von Perplexity (it's not good)

- Das Ende der Hashtags

- und mehr

Zitat des Tages

I am hearing similar things in economics & the social sciences. Not autonomous work, but expert-directed AI is absolutely helping academics do novel research in significant ways. Especially Pro/High Thinking models.

Ethan Mollick in Reaktion auf Kevin Weil von OpenAI auf X:

✨ GPT-5 crossed a major threshold: over the last two months, we’ve heard repeated examples of scientists successfully directing GPT-5 to do novel research in math, physics, biology, CS, and more. If you have an example to share, please reply below! Prizes for the best ones 🧵👇

Als Beispiel siehe etwa Mathematik-Professor Terence Tao auf Mastodon.

Ich habe auch schon einige öffentliche Aussagen dieser Art gesehen, in der Regel in Bezug auf GPT-5 Pro, das bis diese Woche dem 200$-Plan vorenthalten war.

GPT-5 Pro ist jetzt via API verfügbar.

Thema der Woche: OpenAI DevDay

Im Grunde steht bereits alles in der heutigen Überschrift.

Nach GPTs und Plugins kommt jetzt die echte ChatGPT-Plattform. GPTs sind notwendig, aber zu wenig, Plugins sind gescheitert. (Ich glaube, ich habe seinerzeit gar nicht über Plugins geschrieben, mit der Ahnung, dass es nicht weit gehen wird.)

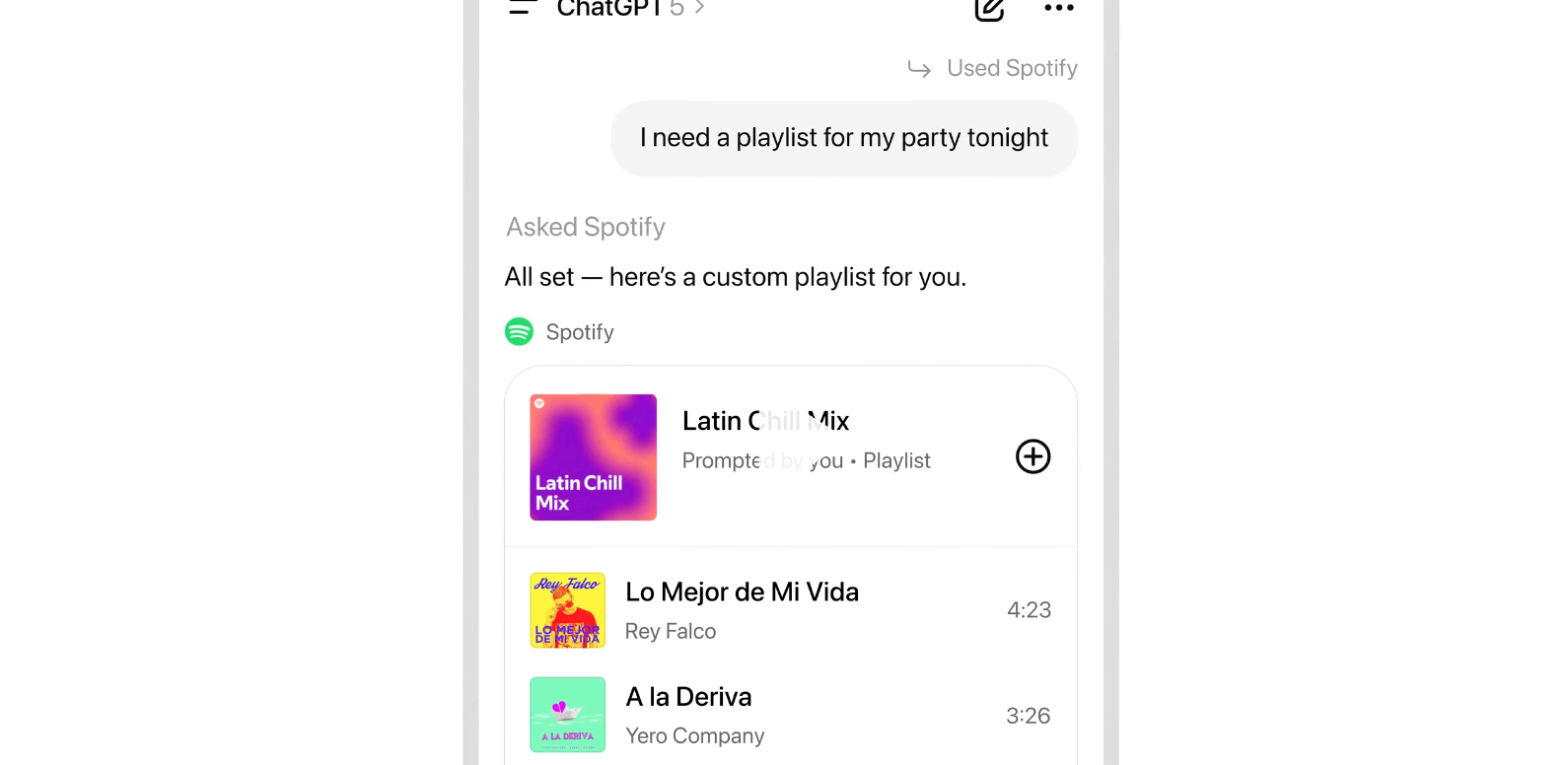

Aber jetzt werden Dienste direkt im Chat nutzbar.

In‑Chat‑Erlebnisse: Nutzer:innen können Apps per Name aufrufen und eingebettete, interaktive Inhalte sehen – z. B. Zillow‑Karten – ohne ChatGPT zu verlassen.

Entwickler‑Tools: OpenAI’s Apps SDK (Preview) und das Model Context Protocol ermöglichen es Apps, Daten, Werkzeuge und Workflows direkt in Chats einzubinden.

Verfügbarkeit: Die Funktion ist für Free‑, Go‑, Plus‑ und Pro‑Nutzer außerhalb der EU verfügbar. (Goddamnit)

Spotify‑Details als Bsp.: Spotifys Integration bietet maßgeschneiderte Empfehlungen, Stimmungs‑/Genre‑/Artist‑Playlists und Klick‑zum‑Anhören; Inhalte der Plattform werden nicht mit OpenAI zum Training geteilt.

Weitere Apps kommen: Künftige Integrationen sind u. a. von Uber, DoorDash, Instacart und AllTrails angekündigt.

Im Stratechery-Interview spricht Sam Altman explizit darüber, dass diese Integration besser für die Partner ist, man hätte auch Dinge machen können, die für die Nutzer:innen besser gewesen wären. Das ist unser kleiner Machiavelli, wie er im von der gesamten Branche gelesenen Newsletter sagt: Wir haben eine faire Plattform für euch gebaut.

Man muss das alles vor dem Kontext der Größe von ChatGPT sehen: Mittlerweile um die 800 Millionen wöchentliche Nutzer:innen. (Das ist sehr groß, riesig sogar für einen Dienst, der noch keine drei Jahre alt ist, aber dass sie keine DAUs nennen, ist... mindestens interessant.)

Diese Integration in die Chat-Oberfläche ist der Beginn der Plattform und des neuen von OpenAI gepushten Paradigmas.

ChatGPTs Distributionsgröße zieht die App/Service-Anbieter hinein.

Es reden bereits einige vom AI-Betriebssystem. Das ist nicht weit weg. Aber die Implikationen gehen weiter, als den meisten klar sein dürfte.

ChatGPT = Apple-Appstore + Google-Suche + WeChat-Superapp

OpenAI braucht Service-Integrationen für ihre kommenden KI-Gadgets.

Die Frage, wo die Apps herkommen sollen, hatte ich für KI-Gadgets allgemein aufgeworfen.

neunetz.comMarcel Weiß

neunetz.comMarcel Weiß

Die größte offene Frage bei all den KI-Gadgets wie Humane AI Pin oder Rabbit R1: Du kannst die App-Rankings einer beliebigen Kategorie nicht auf die Zahl 1 eindampfen. KI ist mächtig, aber ganze Branchen wegabstrahierende Chatbots werden aus offensichtlichen Gründen nicht das nächste große Interface sein. Was also stattdessen tun?

Denn was das Eindampfen bedeutet, kann man bei Humanes AI Pin sehen. Musik beim AI Pin heißt: Tidal. Das hat nicht die Nutzerin ausgesucht. Es ist das Ergebnis eines Hinterzimmerdeals zwischen Humane und Tidal.

OpenAI löst mit der Distributionsmacht von ChatGPT am Desktop und im Smartphone die Frage, wo die Apps für die kommenden Gadgets herkommen sollen.

Das löst nicht zu hundert Prozent die Frage nach dem Long Tail der Apps, lokale ÖPNV-Apps etwa. Es löst auch (noch) nicht die Frage nach der Discovery. Aber das ist alles lösbar.

Wir sehen hier ganz klar eine Vision entstehen: Hier wird ein neuer Tech-Riese gebaut, in dessen Zentrum KI steht. Alles neu gedacht mit KI im Zentrum.

Das ist dann, völlig erwartbar, etwas Neues.

Es vereint Apples Appstore und Googles Playstore (Apps!) mit der Google-Suche (es gab mal eine Zeit, da haben Leute geschrien, KI würde nicht Google ablösen haha!) und (und!) dem Superapp-Konzept von WeChat.

ChatGPT wird Discovery von (Web-)Themen + Basis für Gadgets + die erste Superapp im Westen!

Denn all die Apps werden über kurz oder lang auch in ChatGPT in iOS und Android verfügbar sein. Allgegenwärtig.

Das bringt mich zurück zu meiner allgemeinen Arbeitsthese: Als Sascha mich im Sommer in seinem Podcast fragte, ob es am Ende gar nicht um das Gadget ginge, sondern vielmehr um den KI-Browser als Zugangsweg, war meine Antwort: jein. Weder noch. Denn:

KI ist ein Cloud-Thema.

Zumindest was den Consumerbereich angeht.

KI in der Cloud ist das Zentrum, von dem aus alle Touchpoints bedient werden. Das zu Ende gedacht vereint bisher strikt getrennte Kategorien und schafft ein komplett neues Monster.

Ob sie das erreichen werden, hängt von vielen Faktoren ab. Die Chancen stehen gut.

Es gibt im Westen nur 2 Unternehmen, die dieses Spiel überhaupt spielen können, weil sie die Distribution und die technische Expertise haben: OpenAI und Google.

Über Sora reden wir ein anderes Mal. Aber man muss festhalten: Es ist bereits der zweite Hit von OpenAI nach ChatGPT. Something to ponder.

🦾 Robotik

Figure 03: Vertikal integrierter humanoider Roboter, auf dem Weg zur Massenfertigung

Figure stellt Figure 03 vor, einen humanoiden Roboter mit neuer Hardware und Software, der für Helix, den Einsatz im privaten Haushalt und Massenfertigung entwickelt wurde.

Ich empfehle allen, sich das Werbevideo anzuschauen:

Was Figure auszeichnet, ist die vertikale Integration: Die erste Iteration wurde mit einem OpenAI-Modell betrieben. Helix, das KI-Modell hinter den Robotern, ist eine Eigenentwicklung.

Neue Sensorik und Hände für Helix: Kameras liefern 2x Bildrate, 1/4 Latenz und 60% größeres Sichtfeld; Fingertip-Sensoren erkennen Kräfte ab 3 Grammfür feinmotorische Kontrolle.

Home-Optimierungen: 9% geringere Masse, weichere Textilien, waschbare Soft-Goods, 2 kW induktives Laden in den Füßen und verbesserte Audioleistung (Lautsprecher 2x größer, ~4x Leistung).

(Soft Goods = "Kleidung" für den Roboter)

Strategisch entscheidend ist, dass Figure 03 für Massenfertigung neu konstruiert wurde: Umstellung auf Druckguss/ Spritzguss, neue Zulieferkette, BotQ-Fabrik mit anfänglicher Kapazität bis zu 12.000 Robotern pro Jahr und Ziel 100.000 in vier Jahren.

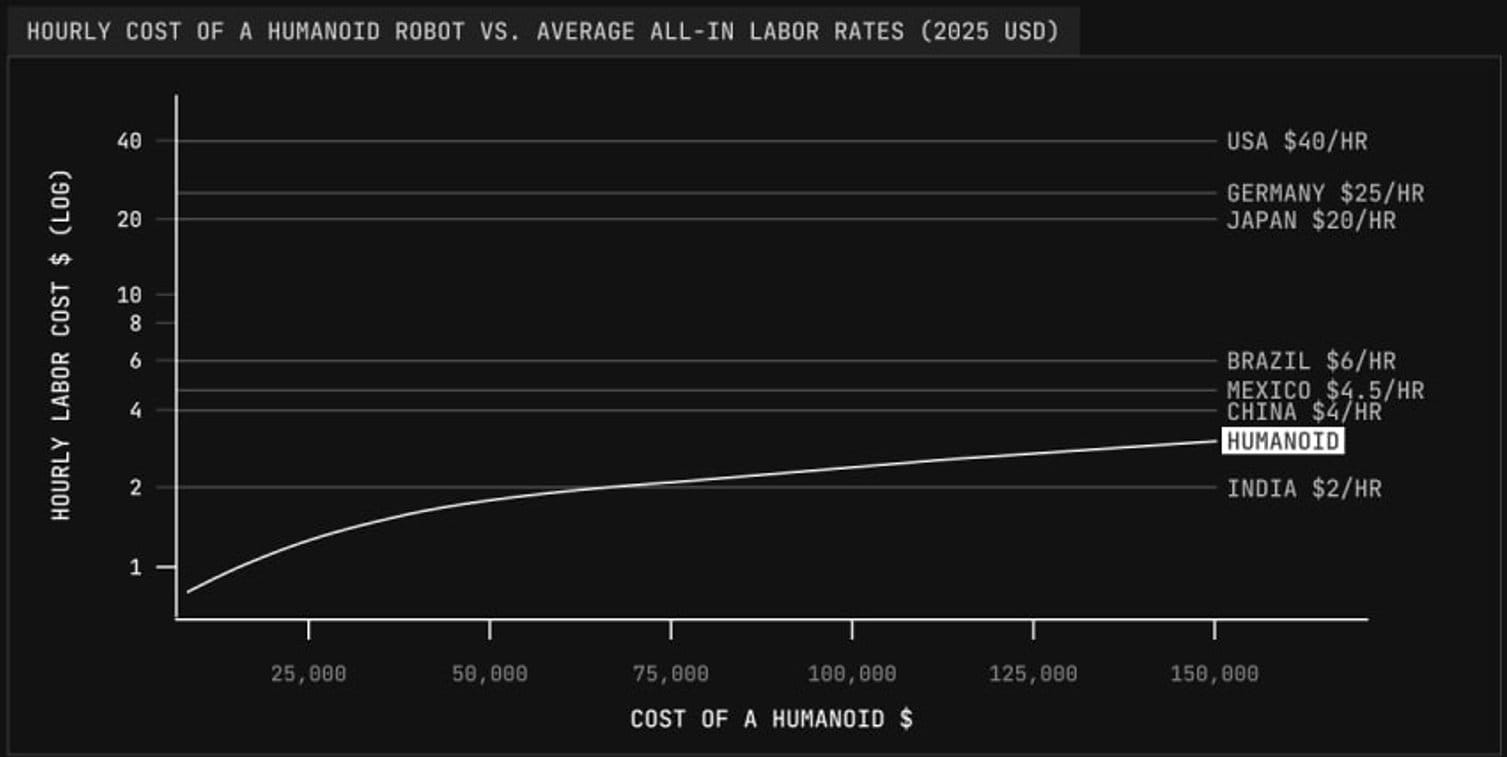

KI-gestützte Robotik wird in den nächsten 20 Jahren zum größten Markt der Welt anwachsen. Innerhalb dieses Marktes wird der humanoide Formfaktor die bestimmende Unterkategorie werden, weil sie am flexibelsten einsetzbar ist. Aus dieser Flexibilität folgen enorme Skaleneffekte dank Massenproduktion.

Das scheint, siehe unten, in Europa noch kaum jemand zu erkennen.

Zumindest das US-Unternehmen Figure ist eine sehr eindeutige Wette auf diese These.

Sie werben auch für den Einsatz im Gewerbe: Schnellere Aktuatoren (2x), bessere Greifstabilität bei variierenden Objekten, drahtloses Laden und 10 Gbps mmWave-Dataoffload für Flotten-Lernen.

• Helix: Figure 03 features a completely redesigned sensory suite and hand system which is purpose-built to enable Helix - Figure's proprietary vision-language-action AI.

• The home: Figure 03 has several new features, including soft goods, wireless charging, improved audio system for voice reasoning, and battery safety advancements that make it safer and easier to use in a home environment.

• Mass manufacturing: Figure 03 was engineered from the ground-up for high-volume manufacturing. In order to scale, we established a new supply chain and entirely new process for manufacturing humanoid robots at BotQ.

• The world at scale:The lower manufacturing cost and the advancements made for Helix have significant benefits for commercial applications. Figure 03 introduces a fully redesigned sensory suite and hand system, purpose-built to bring Helix to life.

Softbank kauft ABB Robotics aus der Schweiz

Jetzt ist der Zeitpunkt, um in Robotik-Fähigkeiten zu investieren und notfalls Robotik-Übernahmen regulatorisch sehr genau zu betrachten.

OpenAI-Investor Softbank übernimmt also ABB Robotics.

Reuters:

SoftBank pushed into humanoid robotics a decade ago with its Pepper robot but later scaled back its ambitions.

Its recent investments in the sector include Berkshire Grey and AutoStore, and it also led a $40 billion funding round in ChatGPT-maker OpenAI and in March bought chip design company Ampere for $6.5 billion.

"SoftBank's next frontier is Physical AI," Son said in a statement.

The deal means ABB has abandoned its original decision to spin off and separately list the industrial automation business, which competes with Japan's Fanuc (6954.T), opens new tab and Yaskawa (6506.T), opens new tab, as well as Germany's Kuka in making factory robots.

"Germany's Kuka" ging 2016 an den chinesischen Konzern Midea.

🤖 KI

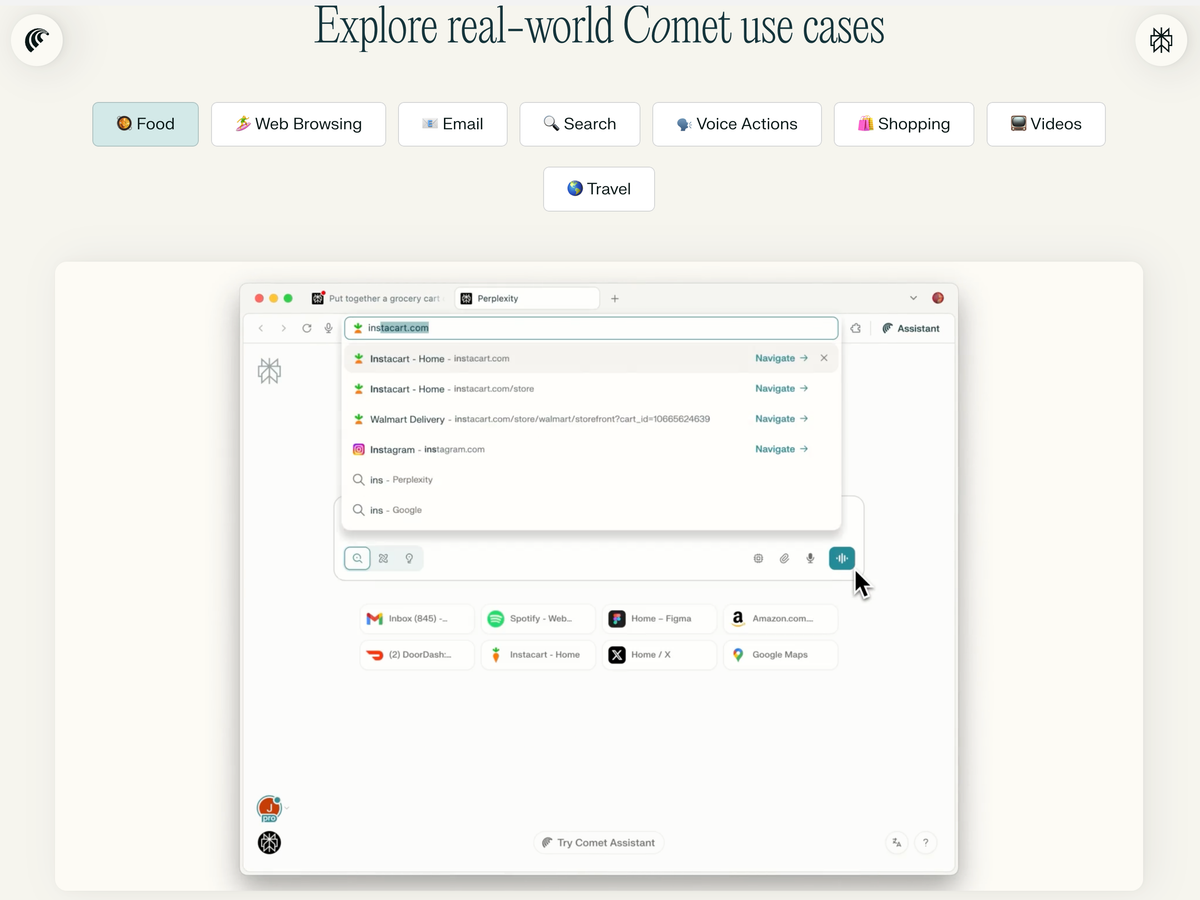

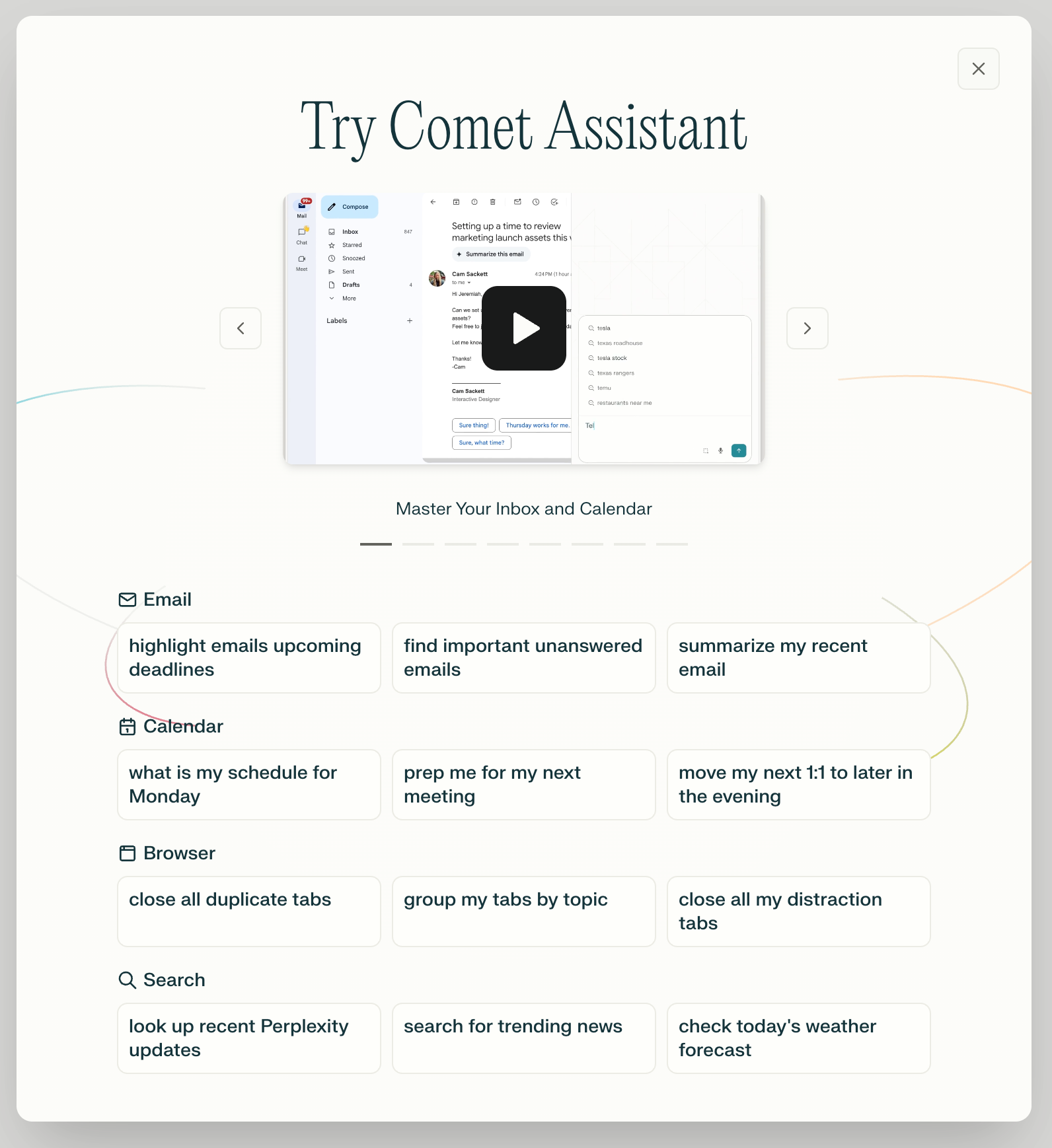

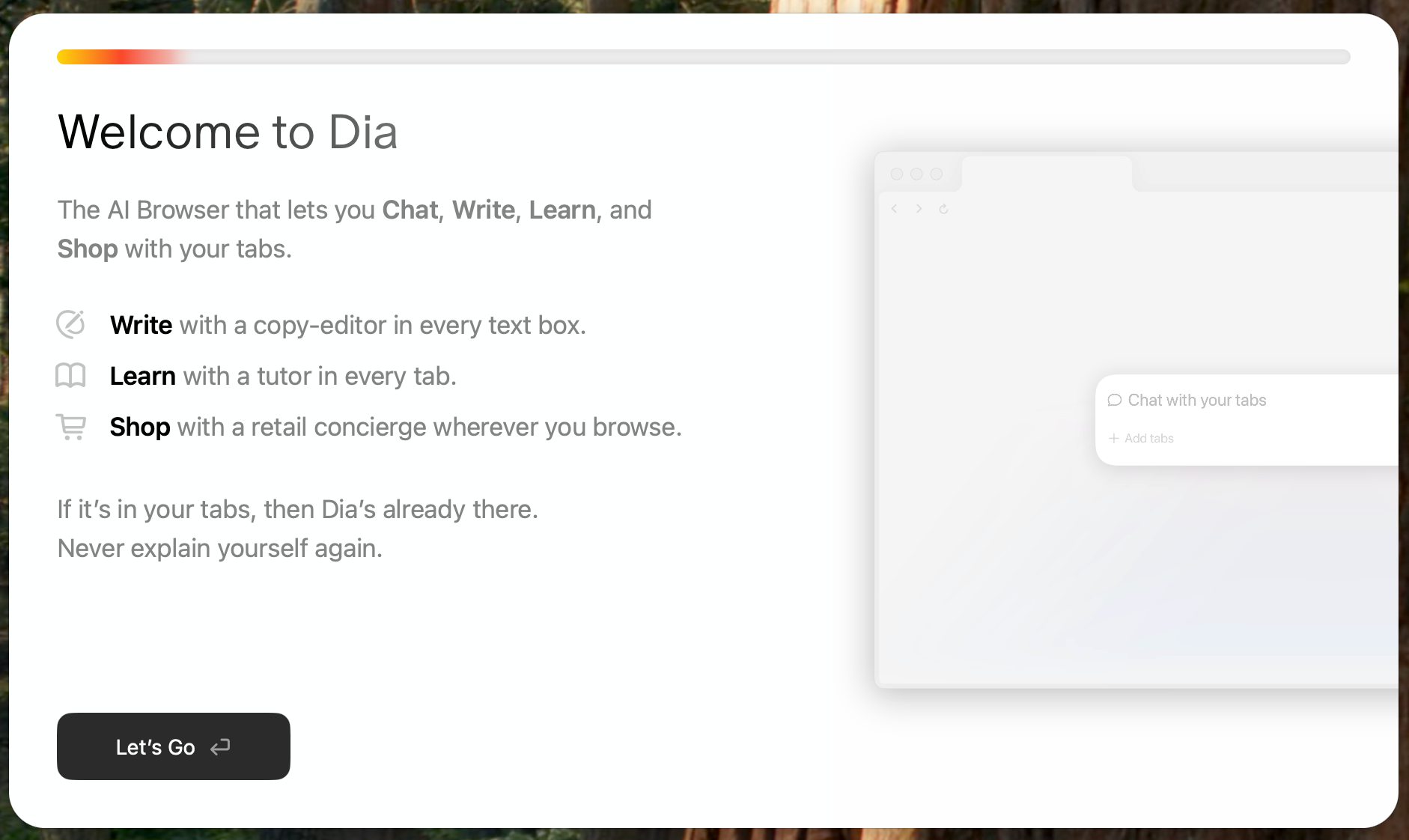

KI-Browser Dia und Comet frei verfügbar

Nachdem das Gericht in den USA entschied, dass Google den Browser Chrome behalten und alle Unternehmen von Apple bis Mozilla weiter bezahlen darf, landet Gemini langsam aber sicher in Chrome. Vertikale Integration incoming!

In der Zwischenzeit, den Atem im Nacken spürend, sind Dia und Comet jetzt frei verfügbar.

Dia hat jüngst eine Memorysuche eingeführt:

Just type @Search Memory into any Chat or Skill to call the right context from your past week of browsing,_ right when you need it._ Ask for that Notion doc your boss sent; summarize discussions with a close collaborator across Slack, Gmail, and Notion; or even build a Skill that helps you reflect on your last week and shape the next one.

Siehe dazu auch meine Analyse vom Sommer:

https://neunetz.com/briefing-267-ki-browser-sind-der-neue-plattformkampf/

Da Perplexity für maximales Wachstum und dafür verschenkte Pro-Pläne die eingebundenen Modelle maximal verblödet*, ist Dia, das mittlerweile zu Atlassian gehört, mein aktueller Kandidat für den vielversprechendsten KI-Browser.

*Es gibt Unterschiede wie Tag und Nacht bei Inferenzanbietern und noch stärker bei Startups, die gegen einen festen Jahres-/Monatsbetrag Zugang zu Modellen anbieten. Letztere können etwa das Kontextfenster gering halten, um möglichst wenige Input-Token zu bezahlen. Das merkt man bei Perplexity etwa daran, dass Follow-Up-Fragen oft ins Leere führen. Es gibt noch andere Hebel, die Kosten und Qualität senken können.

Planbare Lücke zwischen LLMs und SLMs

Das ist sehr wichtig. Frontier AI Performance Becomes Accessible on Consumer Hardware Within 9 Months:

Using a single top-of-the-line gaming GPU like NVIDIA’s RTX 5090 (under $2500), anyone can locally run models matching the absolute frontier of LLM performance from just nine months ago. This lag is consistent with our previous estimate of a 5 to 22 month gap for open-weight models of any size. We find that leading open models runnable on a single consumer GPU typically match the capabilities of frontier models after an average lag of 9 months. This relatively short and consistent lag means that the most advanced AI capabilities are becoming widely accessible for local development and experimentation in under a year.

Diese Lücke macht lokale KI-Integration planbar. Innerhalb eines Jahres bekommt man aktuell Modelle, die die Qualität heutiger Top-LLMs erreicht.

"AI first"

Sangeet Paul Choudary über AI First:

what it means to be architecturally-native to a new technology i.e. rebuilding your system around the logic of a new technology, not merely using it. Four shifts mark such system redesign:Atomic Unit Shift: Redefine the smallest unit of value. Figma (cloud-native) reimagined design work around the design element while Adobe was stuck to the logic of the file Roblox treats interactable experiences, not static games, as its atomic unit, allowing creators and players to co-create persistent worlds.Venetian trade shifted risk management from “chest of coins” to “ledger entry,” enabling credit, insurance, and scale.Stripe treats the API call as its atomic unit, turning payments from bespoke integrations into composable building blocks.Constraints as Design: Embrace limits as features.Containers’ fixed sizes standardized global logisticsTelegraph bandwidth created coded tickers/time-tables that synchronized rail networksTikTok embraced the constraint of ultra-short video length, which optimized its algorithmic discovery loop and drove a new logic for the feed.

Datenpunkte, wie KI das Web verändert

Spannende Daten.

Exponential ViewAzeem Azhar

Exponential ViewAzeem Azhar

A handful of major AI companies hire and control their own fleet of media, because companies realise that what can set them apart is access to original content (studio model of AIs). Everything that depends on traffic is threatened, including high quality journalism (see Azeem’s discussion with The Atlantic CEO Nicholas Thompson • Cloudflare controls ~20% of global web (based on 45M HTTP requests/s) • Cloudflare live -> 71.6% human; 28.4% bot (26th Sept) AI crawlers account for 80% of all bot traffic, with 18% YoY growth • Training traffic: 79-80% (up from 72%); Search traffic: 17% (down from 26%) • User actions: 3.2% (up from 2%) Crawl-to-referral imbalance: • Anthropic shows a 38,065:1, OpenAI 1,091:1, and Perplexity 195:1 • Agents generate up to 39,000+ requests per minute during peak usage • Reports of AI crawlers returning every 6 hours -> creating DDoS-like loads Anthropic’s Model Context Protocol launched in November 2024 • OpenAI adopted MCP in March 2025; Google DeepMind confirmed support in April 2025; Microsoft created an official C# SDK. • 4.3k MCP servers on github

Ich habe die Links zu den Quellen entfernt, weil es Tracking-Links von Substack waren. Links zu den Quellen findet man auf Exponential View.

📺 Medienwandel und vernetzte Öffentlichkeit

Das Ende der Hashtags

Why? Platforms don’t need them anymore. “As a type of metadata, [the hashtag] wasn’t controlled by a platform—it was created by the people, for the people,” Linguistics creator Adam Aleksic wrote in his most recent Substack essay, “Why platforms are killing the hashtag.” “By removing the hashtag, tech platforms are redistributing organizational power away from the users and toward themselves.” Big picture: Platforms have more recently focused on improving their search bar functionalities, rendering hashtags less impactful on overall performance.

Die Macht der Plattformen wird nicht nur den Wegfall der Hashtags sich verschieben, KI-Fähigkeiten machen die großen Plattformen immer undurchsichtiger.

Man vergleiche das hier direkt miteinander: Indem Hashtags verwendet werden, ordnen sich User selbst Gruppen zu. Auf LinkedIn ist der Wegfall von Hashtags wie "#B2B" egal. Aber was ist mit "#blacklivesmatter" oder "#metoo"?

Letztere Bottom-up-Gruppierungen werden ohne Hashtags unmöglich.

Ich gehe davon aus, dass wir ähnliche Verschiebungen an vielen Stellen dank KI bei den großen Plattformen sehen werden.

Eine Folge davon: Die Plattformen werden immer stärker auch vom Vibe her wie Entertainment-TV.

Das öffnet langfristig auch Chancen für Neues.

✴️ Mehr Wissenswertes

Bagel Labs’ “Paris” trains text‑to‑image via fully decentralized experts via Venturebeat:

Why it matters: Paris swaps giant synchronized clusters for eight independently trained diffusion experts and a small router, claiming comparable image quality with ~14× less data and ~16× less compute than a prior decentralized baseline. The appeal is obvious: Train on heterogeneous, scattered GPUs without InfiniBand; deploy with open weights. The catch: Routing and partitioning become your new dark arts.

Ich bin bei so etwas immer vorsichtig, aber das hier wäre ein sehr großer Deal.

Dwarkesh Patel, bester und wichtigster KI-Podcaster (Economist jüngst hilarious: "Did you listen to the new Dwarkesh?") über sein Interview mit Sutton.

Some Thoughts on the Sutton Interview:

LLMs aren’t capable of learning on-the-job, so we’ll need some new architecture to enable continual learning. And once we have it, we won’t need a special training phase — the agent will just learn on-the-fly, like all humans, and indeed, like all animals. This new paradigm will render our current approach with LLMs obsolete. AlphaGo (which was conditioned on human games) and AlphaZero (which was bootstrapped from scratch) were both superhuman Go players. AlphaZero was better. Will we (or the first AGIs) eventually come up with a general learning technique that requires no initialization of knowledge - that just bootstraps itself from the very start? And will it outperform the very best AIs that have been trained to that date? Probably yes. But does this mean that imitation learning must not play any role whatsoever in developing the first AGI, or even the first ASI? No. AlphaGo was still superhuman, despite being initially shepherded by human player data. The human data isn’t necessarily actively detrimental - at enough scale it just isn’t significantly helpful. Even if Sutton’s Platonic ideal doesn’t end up being the path to first AGI, he’s identifying genuine basic gaps which we don’t even notice because they are so pervasive in the current paradigm: lack of continual learning, abysmal sample efficiency, dependence on exhaustible human data. If the LLMs do get to AGI first, the successor systems they build will almost certainly be based on Richard’s vision. . As planes are to birds, supervised learning might be to human cultural learning.

Please let the robots have this one • The Argument Mag:

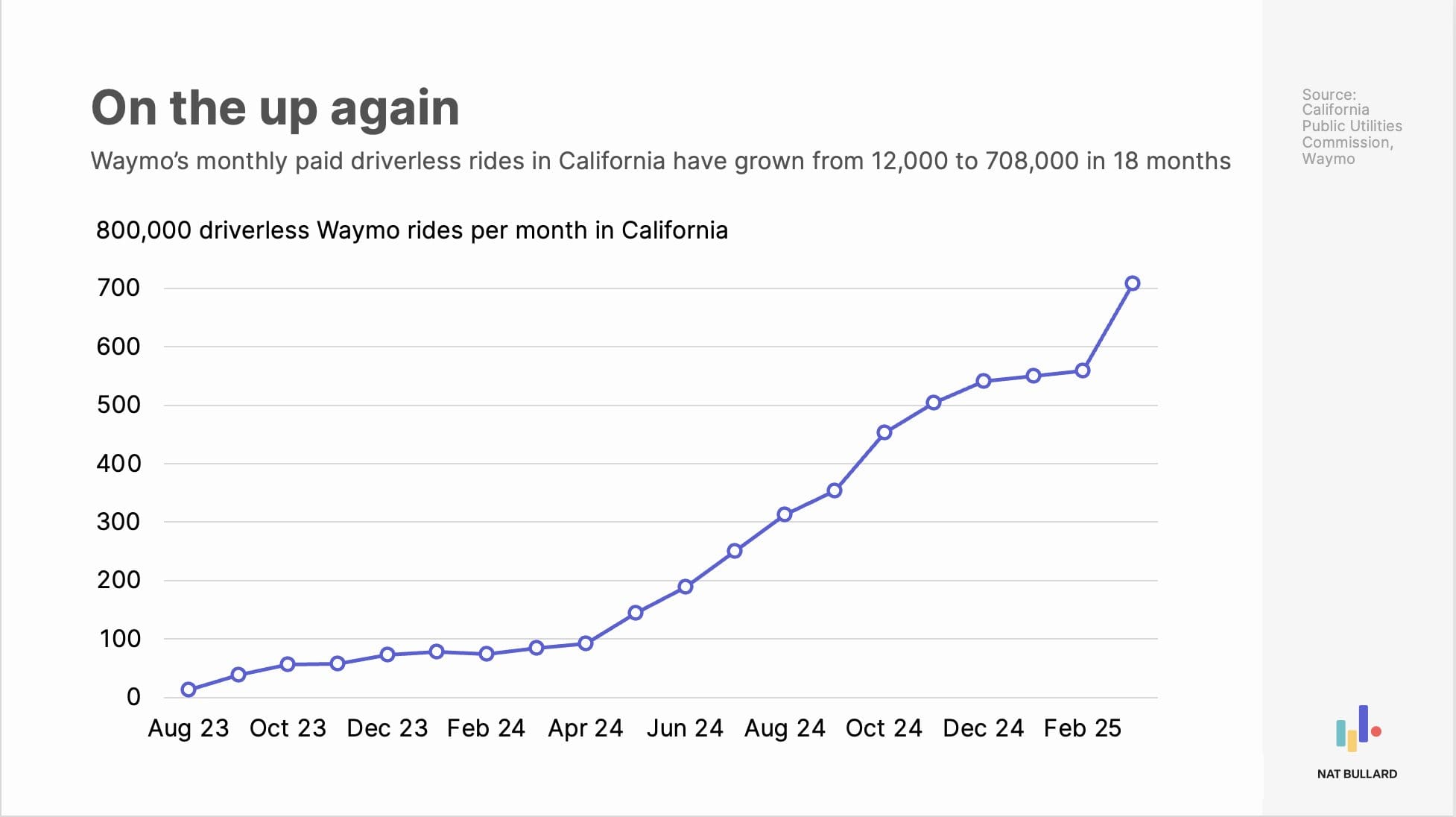

But even in San Francisco where Waymos are a reality, I still run into a lot of Waymo haters. Sometimes they hate the cars for taking jobs from Uber and Lyft drivers. (Though remember how a couple of years ago everyone wanted to ban Uber and Lyft?) Sometimes they hate the cars out of vague anti-corporate sentiment. But often, what they really hate isn’t Waymo at all.

Rausschmeißer der Woche

Ethan Ding: In 100 Years, People Will Marvel at the Idea That...:

in 100 years, people will marvel at the idea that business logic in systems of record ever had a moat, or produced margins [like railroads] we are in a closing window of time where demand for software [logic] has allowed tech companies to make 80% margins for ~2 decades no tmrethan ding 📊 @TheEthanDingsystems of records will not have a moat in 10 years the writing is on the wall for those paying attention everything is compute

~

Briefing 271: ASML + Mistral, Dia + Atlassian, Cash + Onlinehandel, OnlyFans 8 Sep 9:14 AM (last month)

Das ist mal eine Neuigkeit, die es in sich hat: Laut Quellen von Reuters ist ASML dabei, bei Mistral mit umgerechnet 1,5 Milliarden $ einzusteigen und der größte Anteilseigner beim Pariser Startup zu werden.

Wenn das eintrifft, wird das die für Europa mit Abstand wichtigste Wirtschaftsnachricht mindestens des Jahres.

- Europa braucht ein eigenes, starkes, sprich nachhaltig eigenständiges Ökosystem in KI.

- Das im Vergleich zu seinen Peers stark unterfinanzierte Mistral ist mit großem Abstand der wichtigste Modellanbieter in Europa. (Mir fällt sogar außer Universitäten niemand Nennenswertes mit eigenen Modellen in Europa ein; Llama/Qwen/Deepseek-Finetunes zählen nicht.)

- ASML aus den Niederlanden ist eines der zwei weltweit wichtigsten Unternehmen, ohne welche die Weltwirtschaft aufgeschmissen wäre:

- TSMC in Taiwan baut 70%(!) aller global verbauten High-Tech-Chips.

- 100%(!) dieser Chips werden mit Lithographiesystemen von ASML hergestellt.

- Zwischen Lithographiemaschinen und KI-Modellen liegen mindestens zwei separate Wertschöpfungsebenen: Chipdesign (think Nvidia) und Chipherstellung (oben genanntes TSMC). (Und dann braucht es im Grunde mindestens noch jemanden, der die Chips in einem Datencenter verbaut.)

- Vielleicht ist nur Wunsch Vater des Gedankens, aber ich gehe davon aus, dass der Einstieg bei Mistral der Auftakt einer neuen strategischen Ausrichtung von ASML ist. Im Idealfall wachen auch andere europäische Riesen auf.

Unter anderem bietet diese Entwicklung uns allen in ein paar Tagen eine einzigartige Möglichkeit, die Qualität unserer Mediendiät zu überprüfen. Welche europäischen Wirtschaftsmedien werden, wenn es offiziell ist, das weit hinten vermelden? :)

LFG,

Marcel

Im Fokus dieser Ausgabe:

- Transformer können mehr als Sprache

- The Browser Company (Dia) geht an Atlassian und damit Richtung B2B und Arbeitsalltag

- Synthetische Daten für Robotik und Maschinenbau, enorme Chancen für Deutschland

- KI-Browser Fellou verschleiert Herkunft aus China

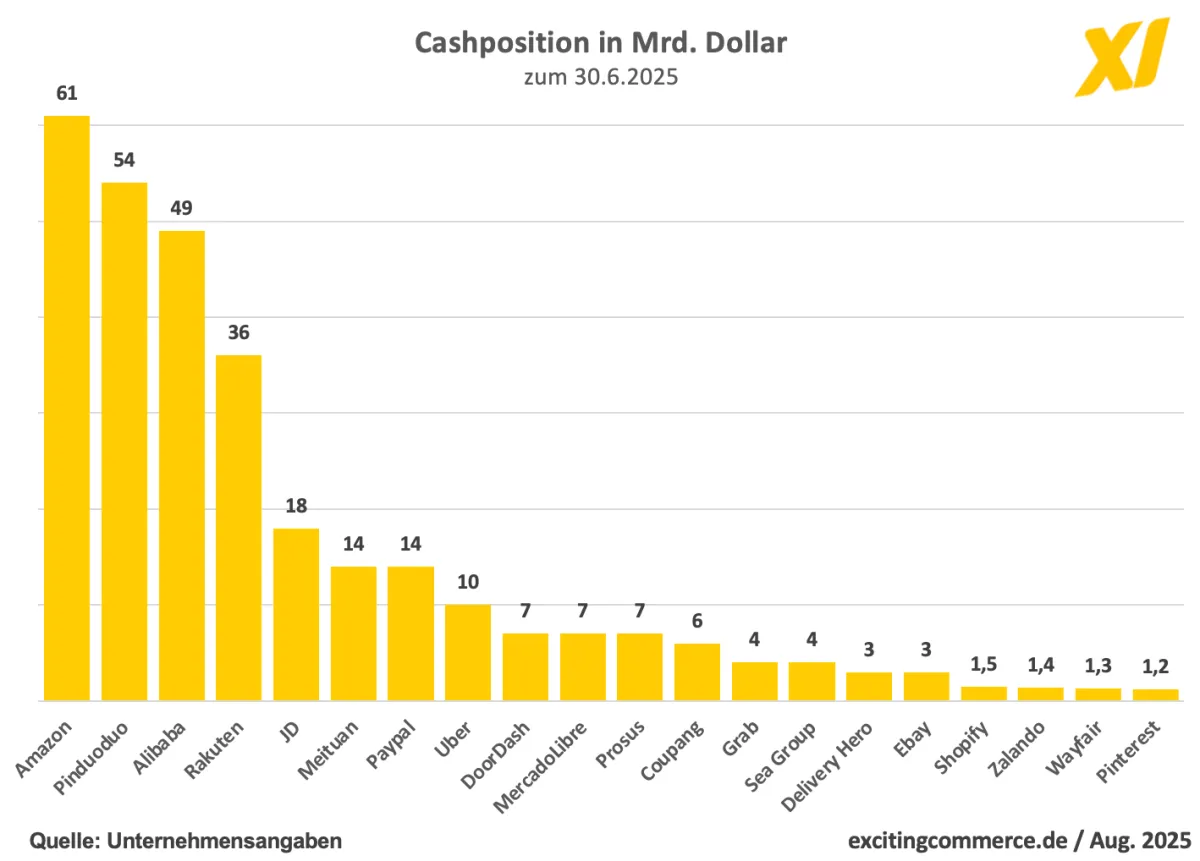

- Die immensen Cash-Reserven der vor allem chinesischen Onlinehandelsriesen

- OnlyFans ist groß genug, um die nächste Mainstream-Plattform werden zu können

- und mehr

Zitat des Tages

Amusing how 99% of people trying to explain LLMs forget that they don't generate the next token, they generate a probability distribution over the entire vocabulary space that the end application is free to sample from

You are very often not presented with the Most Likely Token

Amusing how 99% of people trying to explain LLMs forget that they don't generate the next token, they generate a probability distribution over the entire vocabulary space that the end application is free to sample from

— emozilla (@theemozilla) September 5, 2025

You are very often not presented with the Most Likely Token https://t.co/7RMM4KkeDo

🤖 KI

Was kann ein Token sein?

LLMs sind KI-Modelle, bei denen die Tokens, die kleinsten Sinneinheiten, aus Sprache bestehen. Das muss aber so nicht sein. Transformer-basierte KI-Modelle werden mittlerweile auf unterschiedlichste Datenarten angewandt.

Huawei und Google haben beide bereits mit der Transformer-Architektur Wetter-Modelle erstellt, die nicht nur präziser sind, sondern auch noch weniger rechenintensiv als die alten statistischen Modelle.

Die große Frage, die sich damit stellt, ist, über welche weiteren Datenarten man den Attention-Mechanismus der Transformer-Modelle jagen kann.

Frankfurter Allgemeine Zeitung

Frankfurter Allgemeine Zeitung

Die Frage für Unternehmen lautet nun, welche Arten von Daten im Alltag eingesetzt werden, die eine KI wie eine Sprache erlernen könnte.

The Browser Company (Arc, KI-Browser Dia) geht an Atlassian (horrible SaaS)

Das hatte sicher niemand auf der Bingo-Karte: Atlassian, weltweit seit über 20 Jahren rund um den Globus geliebt für Jira und Confluence, wird The Browser Company, die Macher von Dia, übernehmen, für 610 Mio. Dollar. (CNBC)

The Browser Company:

- Ist ein bisschen Opfer ihres eigenen Timings geworden. Das kann man nicht immer steuern. Ihr erster Browser Arc begann vor dem großen KI-Durchbruch. Der zweite Anlauf, der KI-Browser Dia, kam nachdem Arc nicht genug User fand. (Arc bleibt das beste Browser-Interface.) Da gab es das Startup aber bereits 5 Jahre.

- Das Startup hat das beste UI/UX-Team der letzten 10 Jahre. Das ist und bleibt eine gute Ausgangslage in der heutigen Welt, in der wir enorm mächtige Technologie haben (KI), die weiterhin hinter dem Terminal (Chat) darauf wartet, von den Nutzer:innen entdeckt zu werden.

- Es gibt also unfassbar viel ungehobenes Potenzial beim Thema UI für KI.

Atlassian:

- Ist eines der ältesten B2B-SaaS-Unternehmen der Welt.

- Jira und Co. sind das Gegenteil von dem, was die Dia-Macher gezeigt haben. Ein UI, das niemand mag, aber alle benutzen müssen.

- Wichtiger aber: Atlassian sieht wie alle den KI-Layer am Horizont aufziehen. Der kann sich über alles legen, auch und gerade über SaaS. Damit kann beispielsweise das Onboarding neuer Mitarbeiter:innen für Unternehmen einfacher werden.

- Es hilft sicher enorm, dass der CEO von Atlassian ein Superfan von Arc und Dia war.

Mike Cannon-Brookes, the CEO of enterprise software giant Atlassian, was one of the first users of the Arc browser. Over the last several years, he has been a prolific bug reporter and feature requester. Now he’ll own the thing: Atlassian is acquiring The Browser Company, the New York-based startup that makes both Arc and the new AI-focused Dia browser. Atlassian is paying $610 million in cash for The Browser Company, and plans to run it as an independent entity.

The conversations that led to the deal started about a year ago, says Josh Miller, The Browser Company’s CEO. Lots of Atlassian employees were using Arc, and “they reached out wondering, how could we get more enterprise-ready?” Miller says. Big companies require data privacy, security, and management features in the software they use, and The Browser Company didn’t offer enough of them. Eventually, as companies everywhere raced to put AI at the center of their businesses, and as The Browser Company made its own bets in AI, Cannon-Brookes suggested maybe the companies were better off together.

Gemeinsam: KI-Browser für B2B-SaaS:

Briefing 270: GPT-5, Media Saturn und JD, DeepSeek und chinesische Chips 1 Sep 8:33 AM (last month)

Hi,

man merkt an turbulenten Zeiten, dass es kein Sommerloch bei den Themen gibt.

Nach der Sommerpause gibt es einige Themen aufzuarbeiten. Heute gibt es deshalb unter anderem noch ein paar Anmerkungen zu GPT-5.

Noch ein Hinweis in eigener Sache: Das Briefing wird künftig wie heute Montags erscheinen und nicht mehr Freitags. Weitere Neuerungen dann in naher Zukunft.

Marcel

Im Fokus dieser Ausgabe:

- Die Kosten und das User-Interface von GPT-5 werfen Fragen zur Differenzierung von KI-Produkten auf.

- Auch: GPT-5 im Pro-Modus ist mächtig. Und: Preisgestaltung und das Interface von GPT-5 sind für professionelle Nutzer:innen weiterhin problematisch.

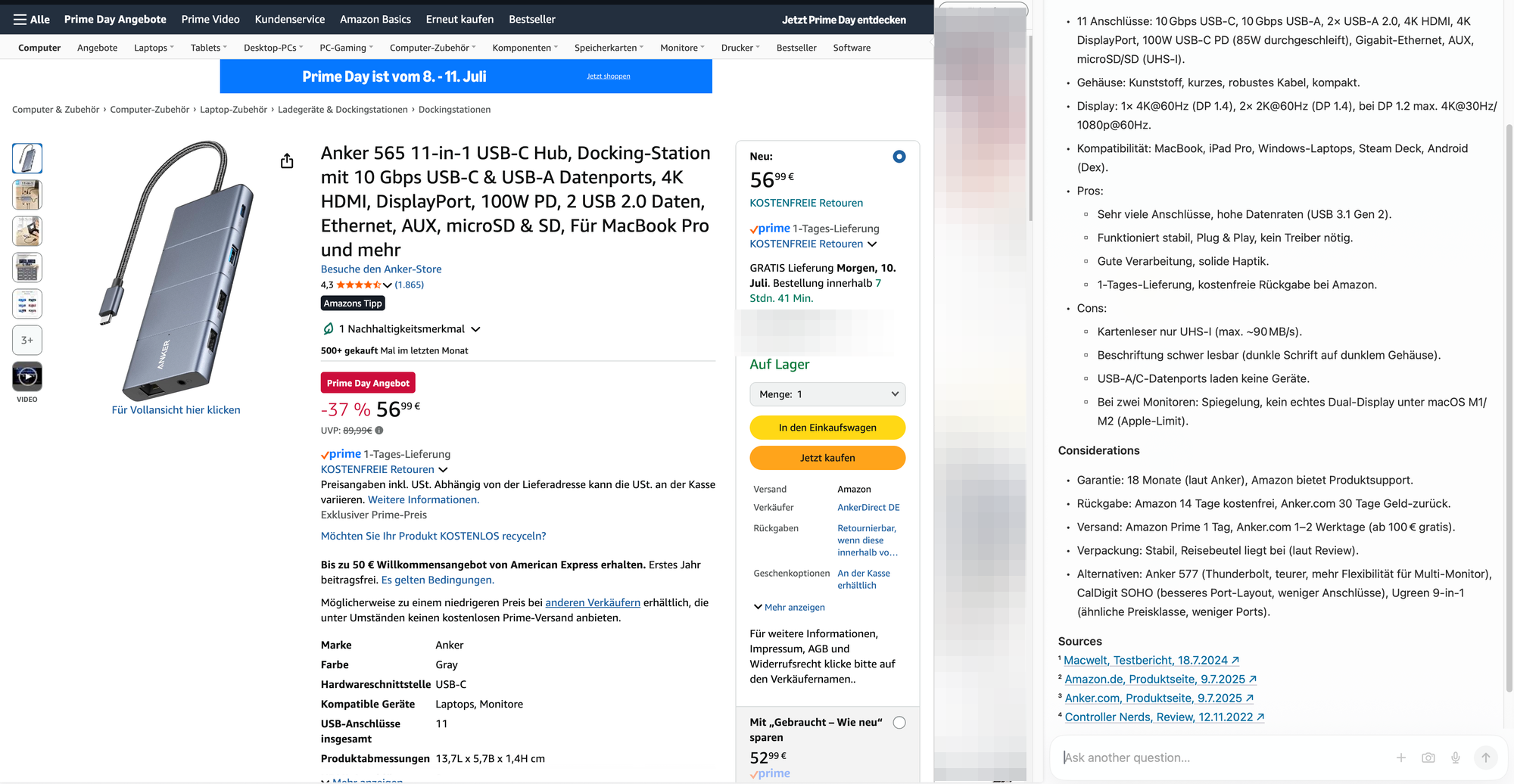

- KI in der Bildung: Eindeutig sinnvoll.

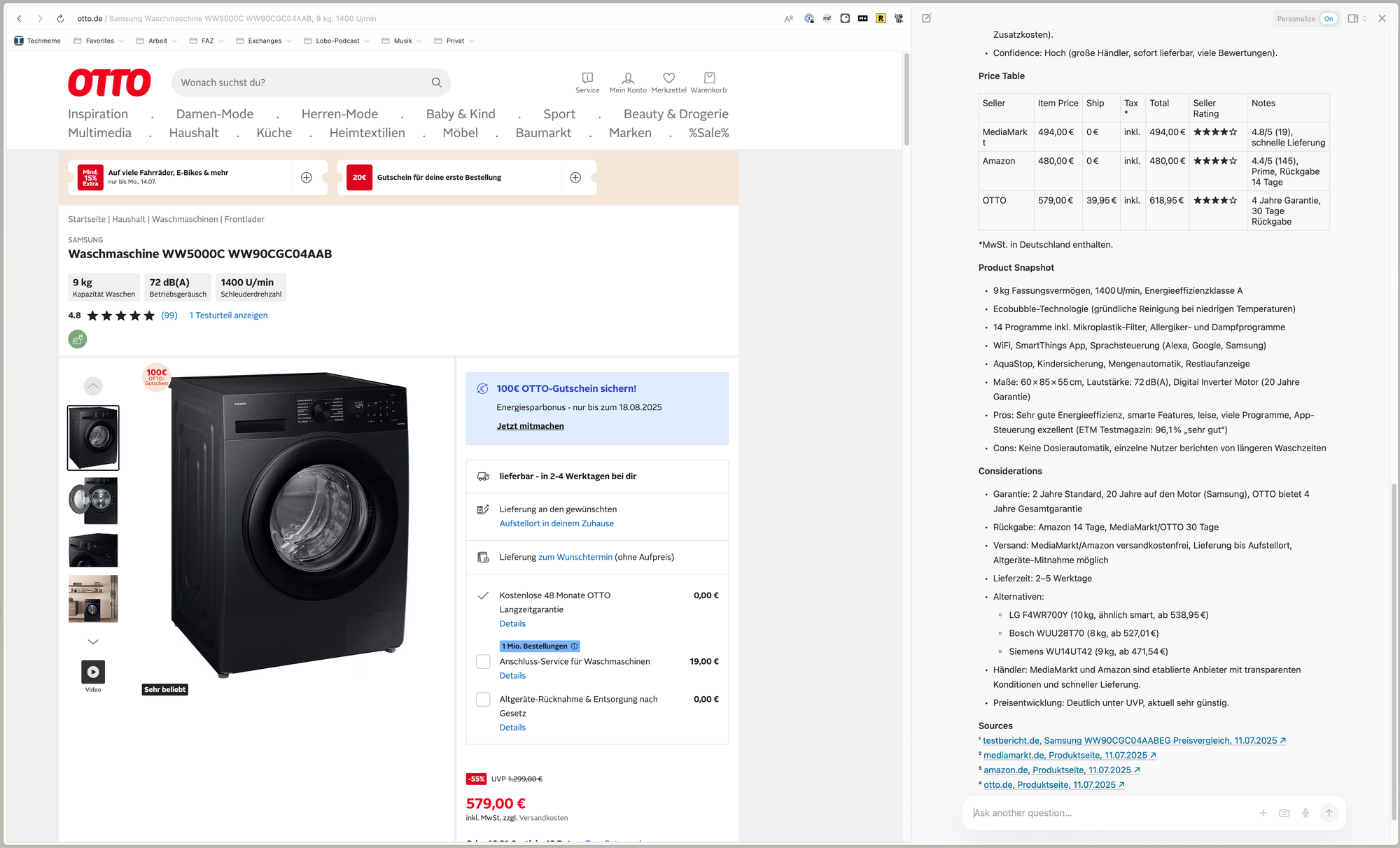

- Sicherheitslücken bei KI-Browsern wie Comet zeigen neue Risiken für Nutzer:innen und ihre Daten.

- Die Übernahme von Media Saturn durch JD könnte den Anfang einer neuen Ära bedeuten für den deutschen Handel. Vor allem, weil in China Geld vorhanden ist, das ohne Probleme große deutsche Unternehmen aufkaufen kann.

- Agentic Commerce verändert die Rolle von Daten und Marktplätzen im Onlinehandel grundlegend.

- DeepSeek und chinesische Chips.

- Solar wird sich global mindestens vervierfachen bis 2030.

- und mehr

Zitat des Tages

At some point the meaning of ‘driving’ and ‘self-driving’ will invert.

At some point the meaning of ‘driving’ and ‘self-driving’ will invert.

— ZΞfi (@zefi) August 5, 2025

🤖 KI

GPT-5, Kosten und Router

So viel Gegenwind, dass es ein Abendessen mit Journalist:innen in San Francisco gab, bei dem Altman und weitere Executives von OpenAI on the record(!) Fragen beantworteten. Eine Folge, wenn nicht nur das eigene Produkt zu den erfolgreichsten der Menschheitsgeschichte gehört, sondern das eigene Marketing noch einen draufsetzt (AGI?).

Sam Altman hat in Interviews mit The Verge und Axios ungewöhnlich offen Fehler beim Launch von GPT-5 eingeräumt: OpenAI habe „einige Dinge total vermasselt“, insbesondere beim Wechsel des Standardmodells und der Kommunikation mit den Nutzer:innen. Während der Launch für Endkund:innen eher durchwachsen verlief, verdoppelte sich wohl das API-Volumen in kurzer Zeit. OpenAI stößt inzwischen an die Grenzen der verfügbaren GPUs. Altman betonte, dass er aus dem Rollout gelernt habe, was es bedeutet, ein Produkt für Hunderte Millionen Menschen über Nacht zu ändern. (The Verge)

Ich schätze, dazu zählen bahnbrechende Erkenntnisse wie, dass man zahlenden Kund:innen nicht ohne Ankündigung Features wegnimmt.

Etwas, das in meinen Augen offensichtlich ist, ich aber erstaunlicherweise bisher nirgendwo gelesen habe:

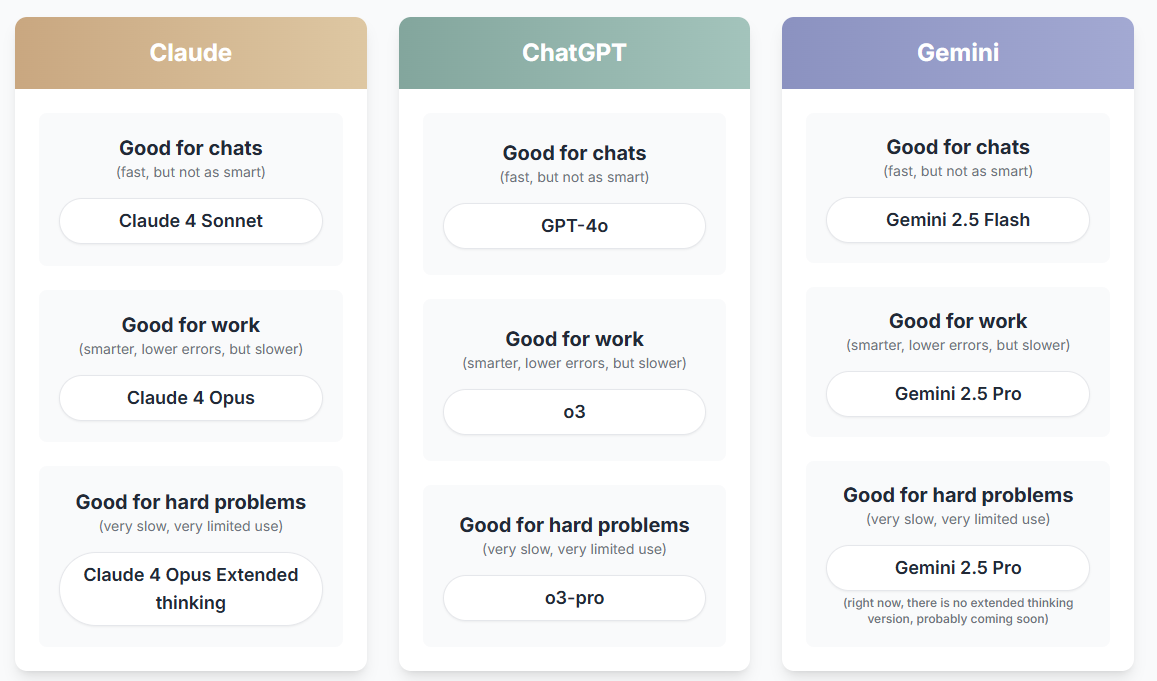

Es ergibt keinen Sinn, dass ein Produkt, das 200$ pro Monat kostet, das exakt gleiche User-Interface hat wie ein kostenfreier (bald werbefinanzierter) Mainstream-Service.

Dass OpenAI an einem Dropdown-Menü scheitert und davon ausgeht, dass sich KI-Produkte über alle Preissegmente hinweg vor allem nur in Nutzungsgrenzen und im Zugang zu besseren Modellen unterscheiden, ist wirklich bemerkenswert.

Product people, where art thou.

Der Router

Das Wichtigste an GPT-5 ist der Router, das eigentliche Produkt, das hier eingeführt wurde. Ein vorgelagertes Modell, das die Anfrage analysiert und dann zum schnellen, kostengünstigeren, leichteren Modell oder zum Thinking-Modell leitet. Anstatt kryptischer Modellnamen.

Das ist einerseits die richtige Entwicklung, andererseits problematisch:

- Die Blackbox LLM wird im B2C-Bereich damit noch blackboxiger. Weil eine vorherige Auswahlmöglichkeit durch einen weiteren Automatismus ersetzt wird.

- E gibt hier einen Interessenskonflikt: OpenAI steuert mit dem Router, welche Kosten ihnen eine Anfrage verursacht. Geringere Kosten = geringere Qualität des Outputs. OpenAI kann ohne, dass die User das nachvollziehen können, die Hebel im Hintergrund Richtung Qualität oder Kosten umlegen.

- Beides, Black Box und Interessenskonflikt, kamen direkt im Launch von GPT-5 zusammen: Augenscheinlich war der Router zu sehr auf Kostenersparnis/Geschwindigkeit geeicht. Das machte GPT-5 für viele User "dümmer". Das Unternehmen behauptete dann, dass es sich um einen Fehler gehandelt habe. Ob das stimmt, wissen wir nicht.

Die Spannung zwischen Komplexität der Technologie und Zugänglichkeit des Interfaces ist ein permanenter Balanceakt; der bei LLMs noch diffiziler geworden ist.

These: LLM-Produkte werden heute immer noch gebaut wie klassische Software, brauchen aber ein grundlegend neues UX-Paradigma. Weil LLMs viel komplexer und idiosynkratischer sind als jeder andere Software-Baustein.

Die Kosten

ChatGPT hat über 700 Millionen wöchentlich aktive Nutzer:innen. (Monatlich aktive Nutzer:innen dürften bei über einer Milliarde liegen.)

Neben leistungsfähigeren Modellen hat hier vor allem der Kostenfaktor eine hohe Priorität für das Unternehmen.

Anthropics Modelle sind oft gleichauf mit OpenAI, oder besser, aber nahezu immer teurer weil rechenintensiver (lies: weniger effizient). Das macht sich in Nutzungslimits bei Claude selbst oder bei Claude in Cursor bemerkbar. OpenAI kann sich das bei seiner Nutzerzahl, B2C wie B2B, schlicht nicht leisten. Wortwörtlich.

GPT-5 Standard ist ungefähr halb so teuer wie GPT-4o. (Das für ChatGPT nicht relevante Modell GPT-5 nano ist bis zu 90% günstiger.)

Der große Endgegner für OpenAI neben den offenen Modellen aus China ist Google. GPT-5 liegt preislich ungefähr auf Niveau von Googles Gemini 2.5 Pro (Basis). Google profitiert hier von seinem vertikal integrierten Techstack bis hin zu den eigenen KI-Chips.

Das Wachstum der Google Cloud Platform, Googles Cloud-Angebot, profitiert enorm von den günstigen, leistungsfähigen Gemini-Modellen und kann aktuell nur so schnell wachsen wie sie die Datencenter ausbauen können.

Mehr Nachfrage als Angebot. It's a theme.

GPT-5-Qualität

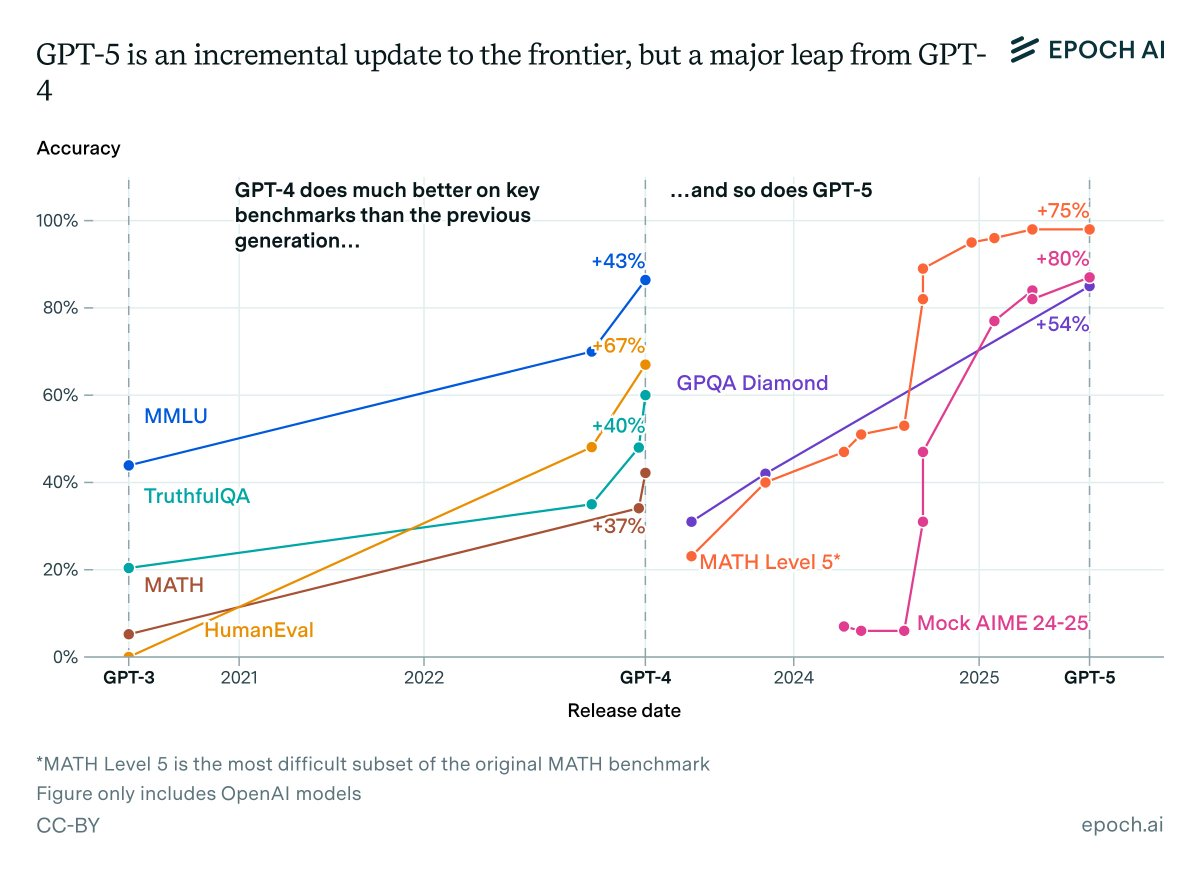

Zunächst: GPT-5 ist ein Opfer des überbordenden Marketings der KI-Startups. Viele haben erwartet, dass OpenAI beim "Versionssprung" von 4 auf 5 etwas ähnliches liefert wie von 3 auf 4. Das war aus einem einfachen Grund unmöglich:

Wettbewerb.

OpenAI, Anthropic, Google und die chinesischen Labs (und mit Abstrichen Mistral) liefern sich ein konstantes Kopf-an-Kopf-Rennen, wer aggressiven Sichern von Marktanteilen mit dem qualitativ besten (und bezahlbaren!) Modell am Markt vorn liegt. Herrscht bei einem Lab für mehr als vier Monate Stille, gehen die Gerüchte los. KI ist immer noch ein (gemessen am Potenzial) vergleichsweise kleiner, aber sehr rasant wachsender Markt. Das erzeugt Druck:

- Sowohl beim Launch von GPT-5 als auch bei Claude im Coding-Sektor: Modelle entwickeln langsam Stickyness bei Powerusern, entweder emtionaler Art wie bei 4o (hochproblematisch), oder auf andere sanfte, nicht quantifizierbare Arten wie Claude im Programmierbereich. (Marktanteile von Claude schwanken

- Talent spielt (mehr oder weniger aradoxerweise) immer noch eine große Rolle im KI-Sektor. Labs, die wahrgenommen werden als nicht an der Speerspitze zu stehen, können Leute schneller verlieren oder, schwerwiegender, nicht neue Toptalente anziehen. (U.a. Metas Problem vor dem Reorg.) Die Nachfrage ist größer als das Angebot. Nicht nur bei der KI-Nutzung, sondern auch bei den KI-Forschenden.

- Die Früchte bei der Technologieentwicklung hängen noch immer tief genug, so dass kein KI-Lab lang an der Spitze der Benchmarks bleibt. Alle werden konstant inkrementell besser.

-> Aus all dem folgt, dass kein Anbieter es sich leisten kann, mehr als eine Generation neuer Modelle zurückzuhalten, nur damit der Marketingsplash größer ist. In Sam Altmans Traumwelt hätten sie auf alle Reasoningmodelle verzichten können und nach einem dreiviertel Jahr Ruhe mit GPT-5 um die Ecke kommen können. BUT ALAS.

Der Unterschied zwischen der ersten Version von GPT-4 und dem heutigen GPT-5-System ist riesig. Und zwischen beiden liegen lediglich zwei Jahre.

(Im Grunde war das erste Reasoning-Modell von OpenAI der eigentliche Nachfolger von GPT-4, also GPT-5 im Geiste.)

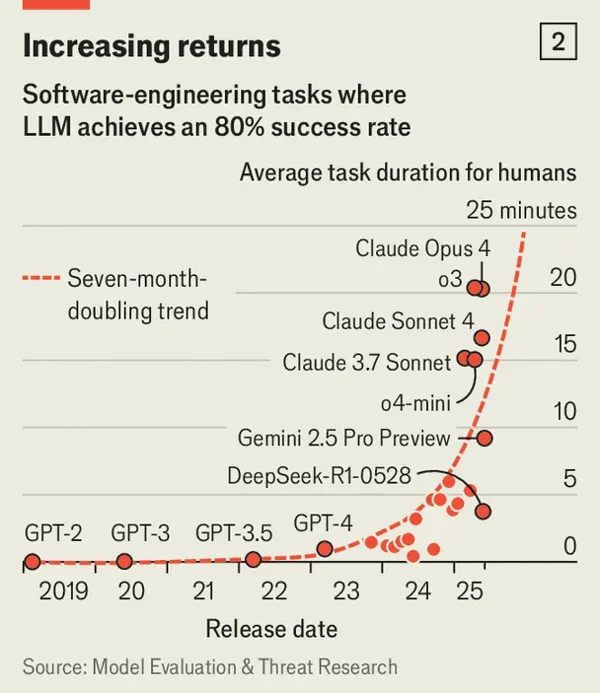

Epoch AI hat das anhand des Math-Benchmarks grafisch aufbereitet:

Aber das ist alles nicht wirklich entscheidend. Relevanter ist die Frage, ob mit GPT-5 neue Dinge möglich sind.

GPT-5 ist, zumindest im teuersten Pro-Modus, sehr mächtig. Erste Top-Forscher:innen sind richtig aus dem Häuschen.

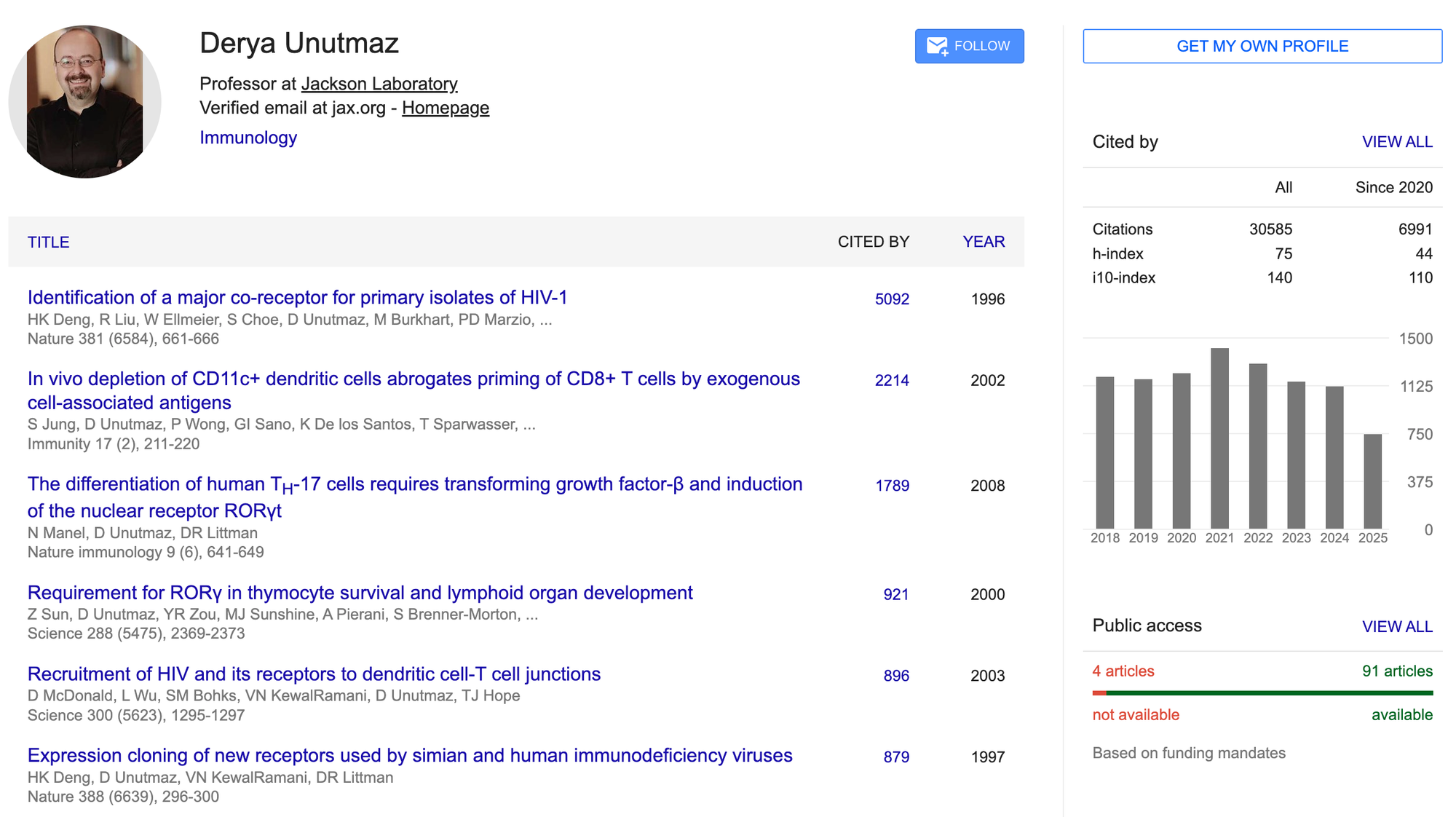

Als Beispiel schauen wir auf die Aussagen von Dr. Derya Unutmaz. Unutmaz ist einer der führenden Immunologen weltweit. Für den Kontext hier sein Scholar-Profil:

Unutmaz hat GPT-5 anhand unveröffentlichter Studiendaten getestet. Das Modell hat die gleichen Ergebnisse aus den Daten produziert wie das hochkomplexe Experiment:

In a social media post, Unutmaz revealed that he used GPT-5 to predict the results of a month-long, highly complex experiment aimed at engineering cells to fight lymphoma. The AI’s predictions, he said, were “astonishingly accurate”. [...]

Unutmaz noted that GPT-5 not only forecasted the entire experimental process and results with high precision, but also suggested design improvements.

P.A. TurkeyCem Cetinguc

P.A. TurkeyCem Cetinguc

Er schreibt auf X auch:

At this point, I may have to revise my timeline for curing aging to a date earlier than the 2040s!

Doubt no more. Thanks to AI, we will treat all diseases and reverse aging!

Unutmaz wurde nach diesen Aussagen von OpenAI direkt für ein Werbevideo eingesetzt.

Ebenfalls ein gutes anschauliches Beispiel für die Planungsfähigkeiten von GPT-5 hat Ethan Mollick hier aufgeschrieben:

One Useful ThingEthan Mollick

One Useful ThingEthan Mollick

If you didn’t catch the many tricks - the first word of each sentence spells out the phrase This is a Big Deal, each sentence is precisely one word longer than the previous sentence. each word in a sentence mostly starts with the same letter, and it is coherent writing with an interesting sense of style. In a paragraph, GPT-5 shows it can come up with a clever idea, plan, and manage the complicated execution (remember when AI couldn’t count the number of Rs in “strawberry”? that was eight months ago).

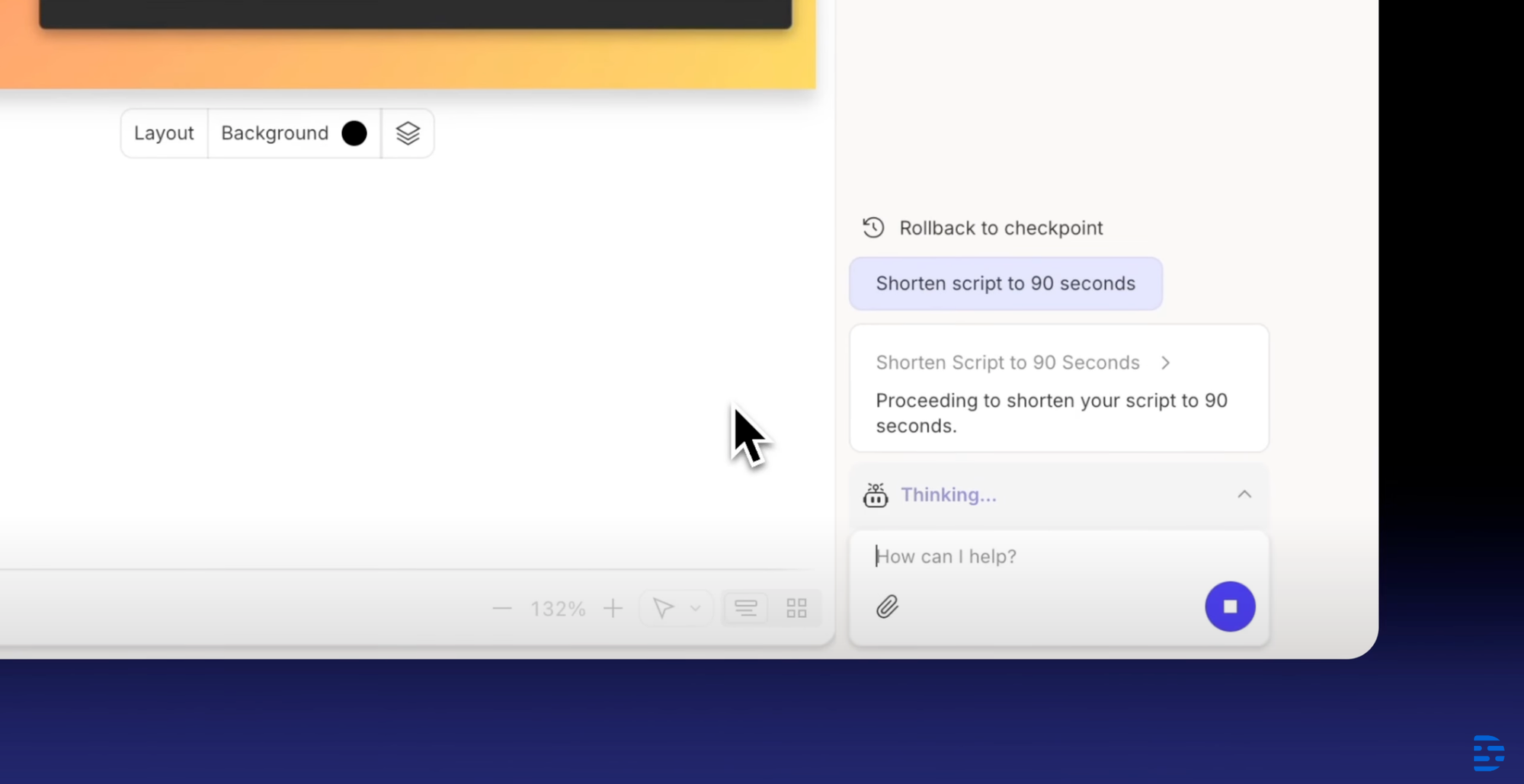

Descript Underlord: KI-Videoeditor

Descript baut mit dem amüsant benannten "Underlord" einen KI-Videoeditor.

Möglich ist das, weil Descript bereits bekanntlich textbasierte Bearbeitung von Audio- und Videoinhalten anbietet. Das LLM-Feature kann über diesen bestehenden Weg auch direkt die Inhalte ändern.

Besser integrierte LLMs, wenn die notwendige Basis dafür bereits gelegt wurde. This is the way.

KI in der Bildung

Sascha Lobo schreibt auf Spiegel über KI an Schulen.

DER SPIEGELSascha Lobo

DER SPIEGELSascha Lobo

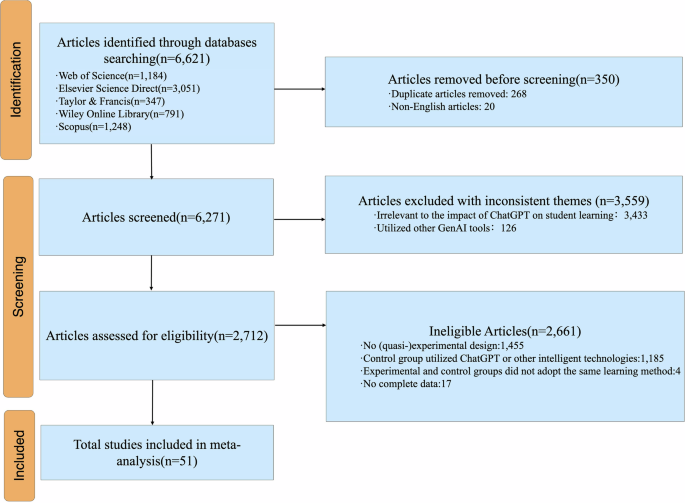

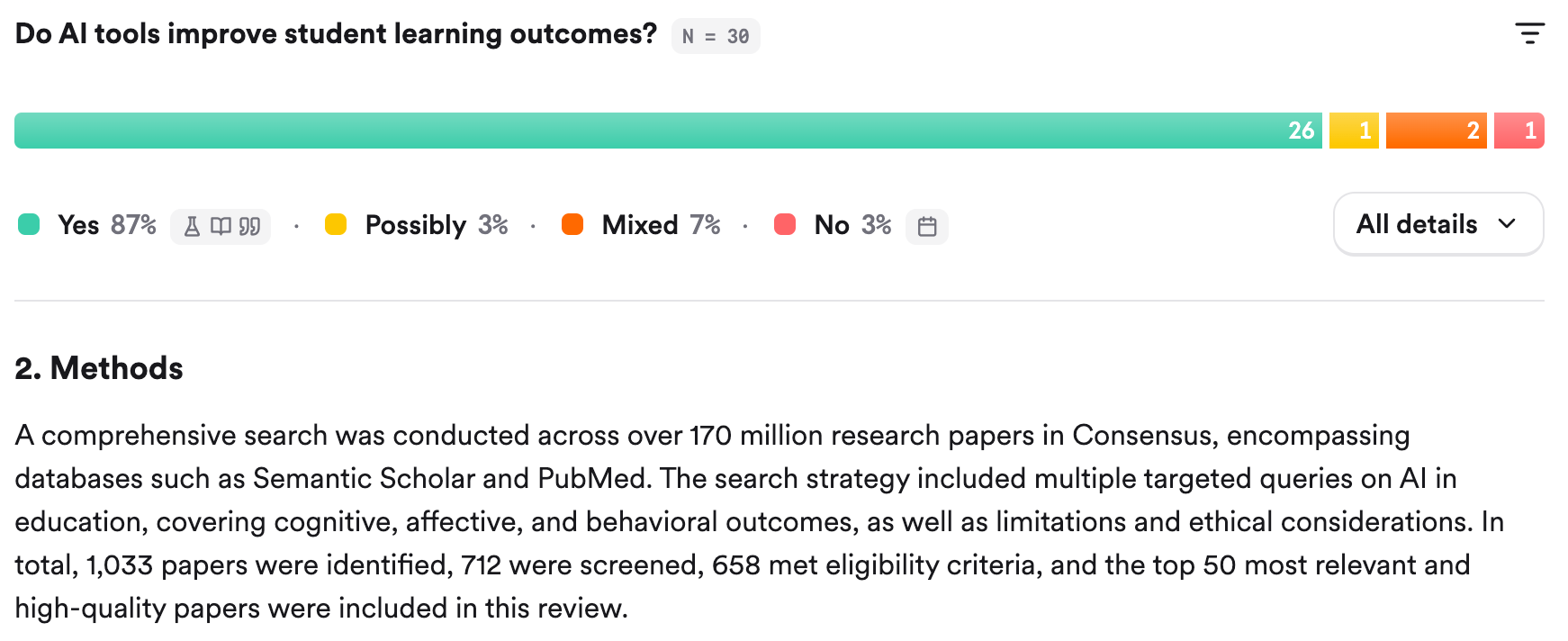

Wir hatten eine der wichtigen Metastudien zu KI in der Bildung hier bereits im Briefing. Es lohnt sich aber, auf die Forschungsergebnisse zu KI in Bildung noch einmal hinzuweisen, weil es so wichtig ist.

Metastudien finden eindeutige positive Effekte bei richtigem Einsatz:

NatureJin Wang

NatureJin Wang

CCSE

CCSE

Die Technologie kann natürlich falsch oder richtig implementiert werden. Auf die Frage, ob KI sinnvoll im Bildungswesen eingesetzt werden kann, antwortet die Forschung eindeutig: Ja.

Ich nutze für Recherchen von akademischen Papern ab und an Consensus. Das aggregierte Ergebnis dieses Recherchewerkzeugs ist, zusätzlich zu ebenfalls eindeutig:

Saschas Kolumne zur KI-Pflicht ist also weniger kontrovers als ein No-Brainer. Zumindest, wenn man sich an der Forschung zum Thema orientiert.

Und last not least besonders wenn man bedenkt, wie KI in Rekordzeit unseren Alltag durchdringt. Augen zuhalten und Erlkönig auswendig lernen allein wird nicht reichen.

Es gibt nur 7 KI-Apps

Briefing 269: Sommerlektüre 7 Aug 10:30 PM (2 months ago)

Hi,

wir sind mitten in der Sommerpause. Deshalb ein etwas anderes Format, mit Schwerpunkt auf Lesetipps und Kommentaren meinerseits. Nächste Woche wird kein Briefing erscheinen. Das nächste Briefing erscheint in zwei Wochen am 22. August. Dazwischen wird es je nach Lage eventuell einzelne Texte auf neunetz.com geben. Kurze Texte werden nicht per Email verschickt.

Wer es verpasst hat, ich habe mit Sascha Lobo über KI-Browser gesprochen. Ein paar weitere Gedanken dazu habe ich hier aufgeschrieben.

Marcel

Lektüretipps, Zitate und Anmerkungen zu:

- Ökonomie der Superintelligenz

- Wie würde überhaupt geopolitische Unabhängigkeit bei KI für uns aussehen?

- Wie sich Chinas KI-Ansatz von den USA unterscheidet und warum das so ist

- Datencenterausbau -> Finanzkrise?

- TikTok Shop in Deutschland

- Buchempfehlungen

- und mehr

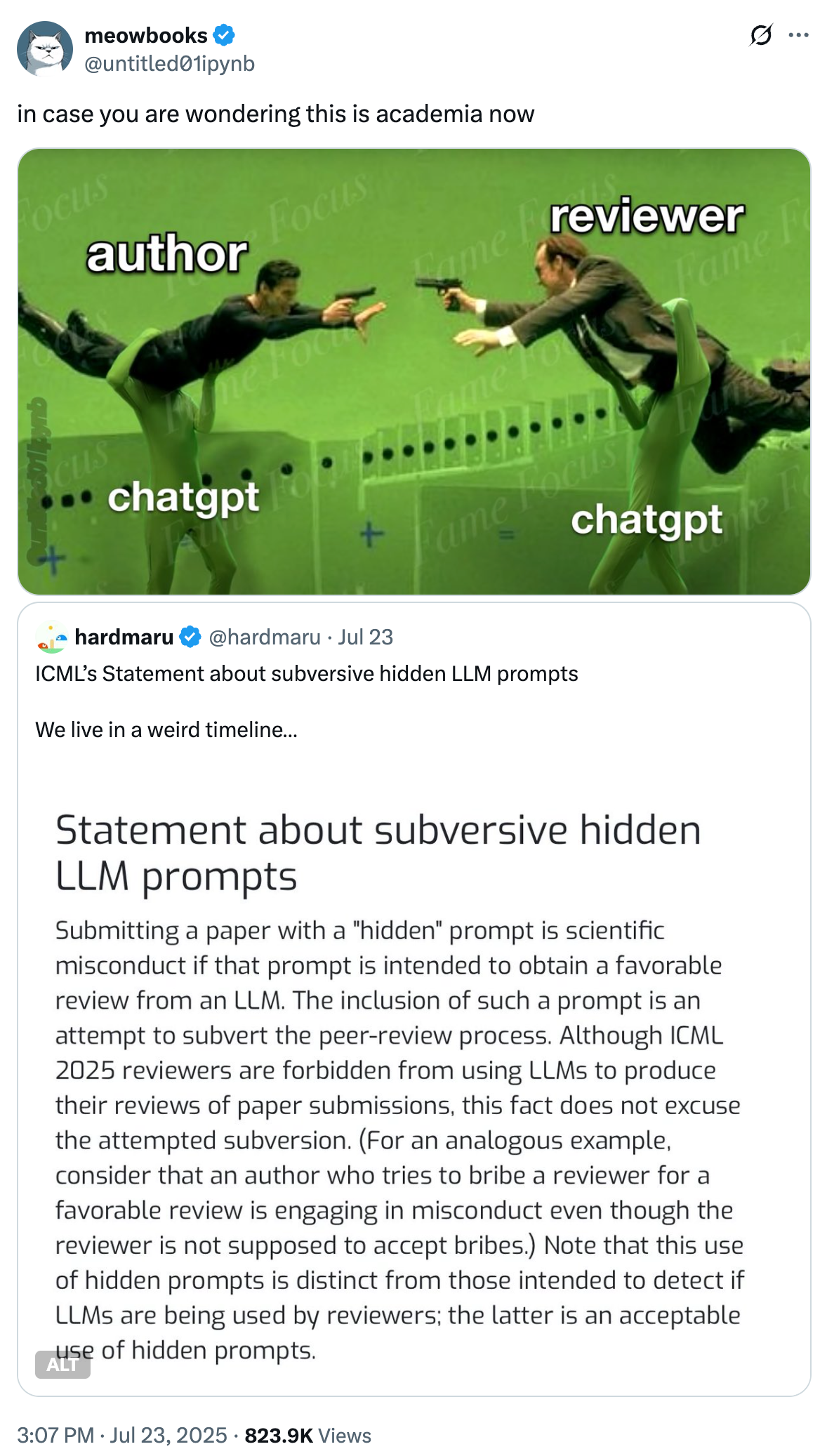

Nicht nur die akademische Welt:

Die Ökonomie der Superintelligenz

The EconomistThe Economist

The EconomistThe Economist

Die Ökonomie der Superintelligenz: Was passiert, wenn KI wirklich „alles" oder zumindest fast alles kann?

Der Economist stellt sich in einem jüngeren Titelbriefing die Frage, der sich in Europa die Eliten noch nicht wirklich zu stellen scheinen: Was, wenn die Voraussagen aus dem Silicon Valley bezüglich KI-Entwicklungen ansatzweise zutreffen?

Ich war seit Ende 2022 (wie der Rest der Welt) beeindruckt, was bei KI passiert, aber verhalten bis skeptisch, was die Voraussagen anging. Seit ich intensiver Insidern der Branche als auch der Forschung folge (ich mache einmal im Monat einen Überblick über KI-Forschung für die FAZ), ist meine Skepsis dem bedrückenden Gefühl gewichen, dass vor unseren Augen die Basis für eine neue Wirtschaftsordnung entsteht, die bis jetzt nahezu komplett an Europa vorbeigeht.

Die Dringlichkeit der Lage wird nur in den USA erkannt -wo die Hyperscaler historische CapEx-Rekorde aufstellen und in den Quartalsberichten mitteilen, dass Nachfrage kontinuierlich höher ist als ihr Angebot wie jüngst Google mit Ausgaben, Status Quo und Aussichten für GCP. Und in China, das sich mit Alibabas Qwen, den DeepSeek-Modellen und jüngst Kimi K2 von Moonshot an die Speerspitze der "offenen" KI-Modelle gesetzt hat. (Offen heißt hier: Kann leichter angepasst werden und kann auf eigenen Servern betrieben werden. Kein Tag mehr, an dem kein Konzern ein weiteres eigenes Deepseek- oder Qwen-Finetune verkündet.)

Wie dem auch sei, die Signale aus der Forschung und aus den Labs sind eindeutig, die Nachfrage gemäß der Quartalszahlen der Hyperscaler ebenfalls. Die Qualität der jüngsten Modelle und die ersten für den Alltag benutzbaren Agenten-Produkte auch.

Wir brauchen nicht "AGI" für umwälzende Veränderungen. Es reicht eine Entwicklung mit vergleichbarer Geschwindigkeit. (Es würde sogar bereits der heutige Stand und mehr Fokus auf Produkte, Dienste und Interfaces reichen für umwälzende Veränderungen in den nächsten 10-20 Jahren.)

Wie dem auch sei. Der Economist hat sich an der sehr schwierigen Frage versucht, was konkret passiert, wenn KI zu explosionshaftem Wachstum führt.

UNTIL 1700 the world economy did not really grow—it just stagnated. Over the previous 17 centuries global output had expanded by 0.1% a year on average, a rate at which it takes nearly a millennium for production to double. Then spinning jennies started whirring and steam engines began to puff. Global growth quintupled to 0.5% a year between 1700 and 1820. By the end of the 19th century it had reached 1.9%. In the 20th century it averaged 2.8%, a rate at which production doubles every 25 years. Growth has not just become the norm; it has accelerated.

If the evangelists of Silicon Valley are to be believed, this bang is about to get bigger. They maintain that artificial general intelligence (AGI), capable of outperforming most people at most desk jobs, will soon lift annual GDP growth to 20-30% a year, or more. That may sound preposterous, but for most of human history, they point out, so was the idea that the economy would grow at all.

Einer der wichtigen Punkte ist die Tatsache, dass Kapital, also die Möglichkeit in Produktionsanlagen zu investieren, wichtiger wird:

If you add machines but not workers, capital lies idle. But if machines get sufficiently good at replacing people, the only constraint on the accumulation of capital is capital itself.

Suppose production was fully automated, but technology did not improve. The economy would settle into a constant rate of growth, determined by the fraction of output that was saved and reinvested in building new machines.

Das scheint mir ein Punkt zu sein, der von vielen ausgeblendet wird, die behaupten, wir sehen mit KI lediglich die Wiederholung der Industrialisierung mit ihren Automatisierungen körperlicher Arbeit. Denn das trifft eben nur zum Teil zu. KI wird mindestens punktuell menschliche Arbeit komplett aus einzelnen Wertschöpfungsebenen herausziehen.

Der Unterschied zwischen 90% und 100% Automatisierung einer wirtschaftlichen Tätigkeit hat stärkere Implikationen für Wirtschaft und Gesellschaft als die Differenz eines Automatisierungsgrades (oder Augmentierungsgrades) einer solchen Tätigkeit von 10% zu 90%.

(Selbst hochgradig automatisierte Fabriken brauchen spezialisierte Ingenieur:innen, die sich um Steuerung und Wartung kümmern. Übrigens ein Grund, warum Manufacturing weltweit, selbst in China, als Jobmarkt auf dem Rückmarsch ist: Fertigung ist heute immer stärker eine hochspezialisierte Domäne für wenige, gut ausgebildete Menschen.)

Eine Prognose im Economist laut einem Paper ist, dass die Volkswirtschaft so schnell wächst, dass die im Vergleich langsamer wachsenden Gehälter trotzdem ansteigen:

In Mr Nordhaus’s paper, less-than-perfect substitutability between labour and capital during an AI breakout leads to an explosion in wages. Strangely, wages still shrink as a share of the economy, since the economy is growing even faster (see chart). There is some evidence of this dynamic already within tech firms, which tend to pay superstar wages to top workers, even though the share of such firms’ income that goes to owners is unusually high.

Hier zeigt sich, wie "Wirtschaftswachstum" in der Öffentlichkeit oft missverstanden wird. Wachstum vergrößert den Kuchen, die Gründe sind vielfältig, überhaupt nicht zwingend steigender Ressourcenabbau. Und der Kuchen selbst besteht aus vielen beweglichen Teilen, die sehr unterschiedlich auf einander reagieren.

Neben der wachsenden Bedeutung von Kapital steigt auch die Ungleichheit am Arbeitsmarkt, weil einzelne Tätigkeiten mit KI produktiver werden:

Averages conceal variation. Explosive wages for superstars would not console those with more mundane desk-jobs, who would have to fall back on the parts of the economy that had not been animated. Suppose, despite AGI, that technological progress in robotics were halting. There would then be plenty of physical work requiring humans, from plumbing to coaching sports. These bits of the economy, like today’s labour-intensive industries, would probably be affected by “Baumol’s cost disease” (a wonderful affliction for workers) in which wages would grow despite a lack of gains in productivity.

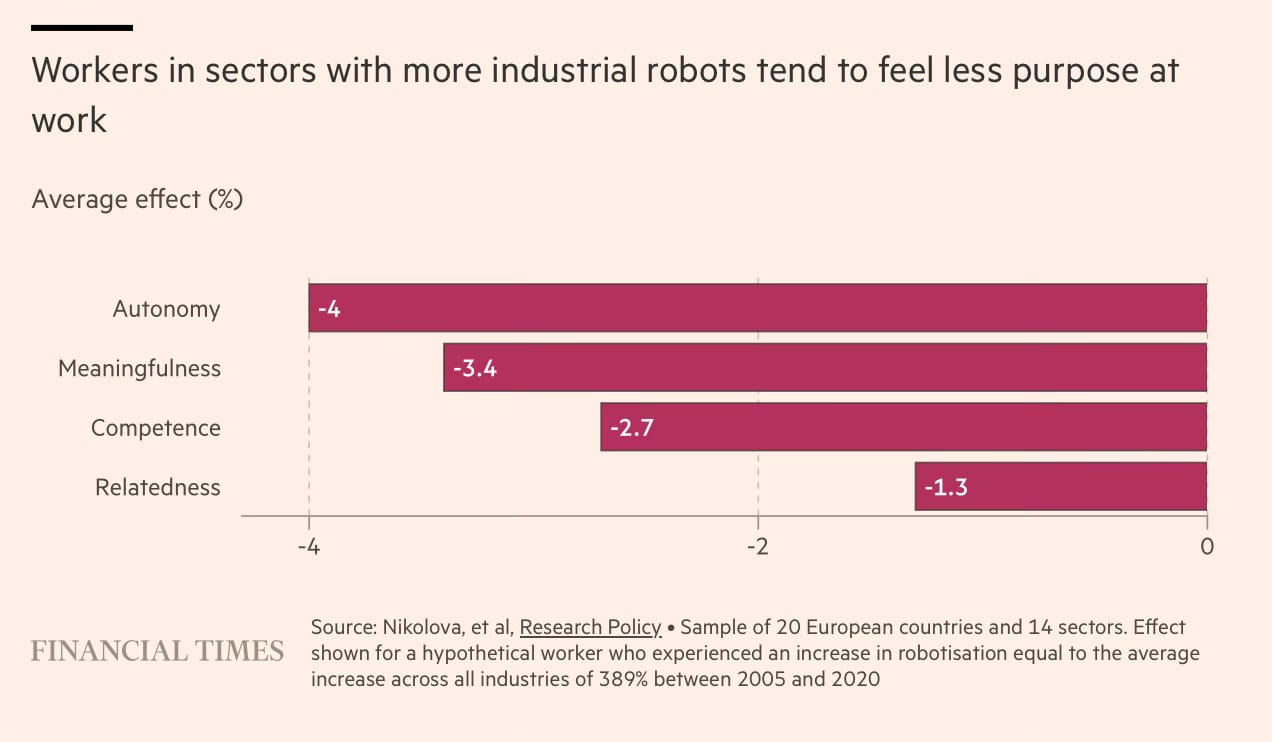

"that technological progress in robotics were halting": Wer hier im Briefing aufmerksam mitliest weiß, dass das nicht der Fall sein wird. Es wird mit Hochdruck an KI-Modellen für Robotik gearbeitet. China hat den Aufbau von heimischer (humanoider) KI-Robotik zu einem der höchsten Industriepolitik-Ziele erklärt. (Unitree freut's.)

Humanoide Robotik wird aber auf absehbare Zeit nicht „alles“ „überall“ ersetzen. Stattdessen wird es „Baumols cost disease“ noch verstärken.

Völlig unklar ist heute, wie sich Preisniveaus von Produktkategorien entwickeln werden:

Some worry that the Baumol effect would be so acute as to limit economic growth. When the price of something collapses, people buy more of it. But its share of consumer spending can still fall. Take food. In 1909 Americans bought 3,400 calories-worth of food per day (including waste), which cost 43% of their incomes. Today they buy 3,900 calories-worth, but that costs just 11% of their incomes. If prices fall faster than quantity increases, the measured economy becomes dominated by whatever it is that cannot be made more efficiently. “Growth may be constrained not by what we are good at but rather by what is essential and yet hard to improve,” wrote Mr Aghion and his colleagues.

Das trifft im Grunde auf fast alles zu: Relativ unklar, wie die volkswirtschaftlichen Effekte in Summe am Ende tatsächlich aussehen werden.

Umso wichtiger, dass auch hierzulande ernsthafte Debatten darüber geführt werden, was passiert, wenn die Prognosen aus den Labs zutreffen - und, last but most certainly not least wie wir es realistisch(!) beeinflussen können.

Unterschätzte KI

Ebenfalls im Economist:

The EconomistThe Economist

The EconomistThe Economist

The boosters could, of course, be over-optimistic. But, if anything, such prognosticators have in the past been too cautious about ai. Earlier this month the Forecasting Research Institute (fri), another research group, asked both professional forecasters and biologists to estimate when an aisystem may be able to match the performance of a top team of human virologists. The median biologist thought it would take until 2030; the median forecaster was more pessimistic, settling on 2034. But when the study’s authors ran the test on Openai’s o3 model, they found it was already performing at that level. The forecasters had underestimated ai’s progress by almost a decade—an alarming thought considering that the exercise was designed to assess how much more likely ai makes a deadly man-made epidemic.

(Hervorhebung von mir)

Dazu passend auch diese Entwicklung:

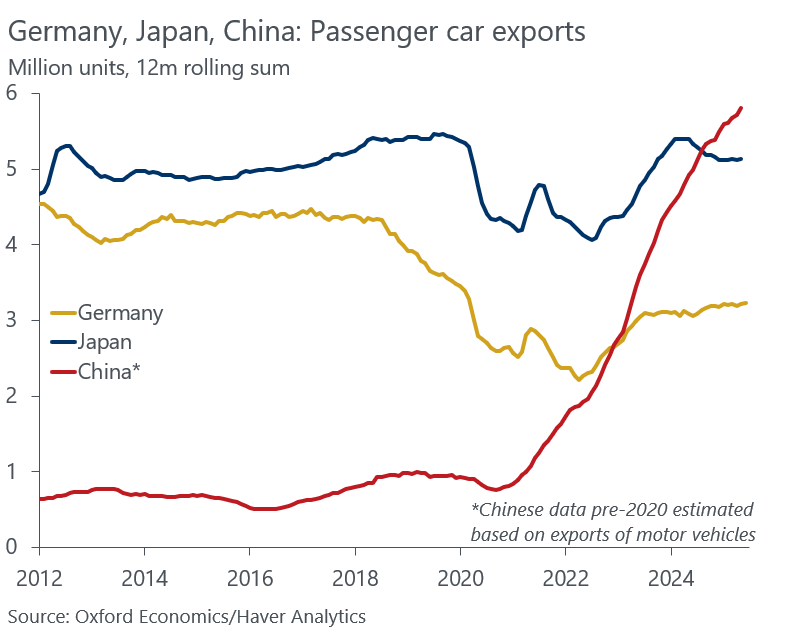

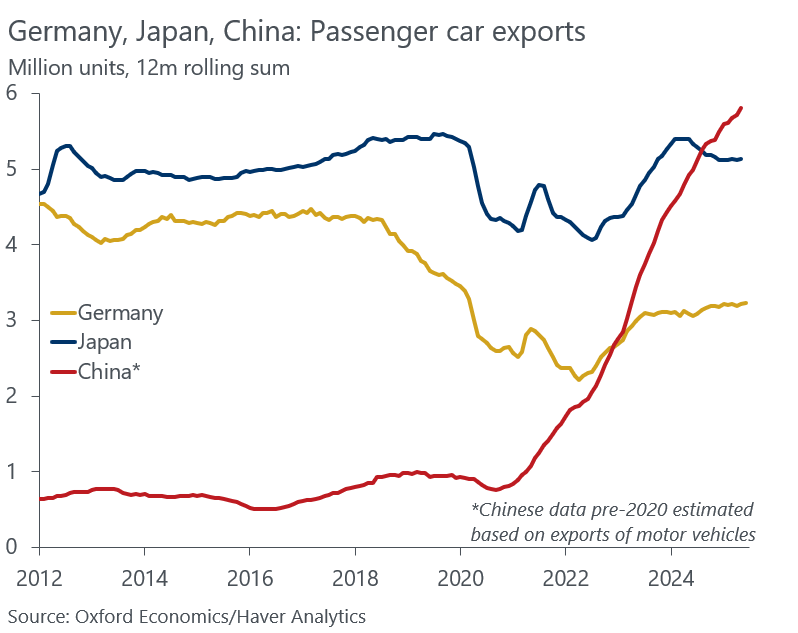

Als die deutsche Automobilindustrie sich vom Massenmarkt verabschiedete

Man sieht in diesem Chart hervorragend den Zeitpunkt, als sich VW und die anderen deutschen Automobilkonzerne mit Ansage auf die Marge zu konzentrieren begannen und den Massenmarkt damit aufgaben.

Selbst Japan liegt heute höher und China scheint gerade erst anzufangen.

Wie immer bei diesem Thema: Software-Plattformen und Services entstehen auf einer breiten Hardware-Basis. Wer diese nicht hat, hat auch keine Chance auf, zum Beispiel, softwarebasierte Geschäftsmodellinnovationen.

(Hinzu kommen alle Folgen der größeren Vielfalt an Formfaktoren dank E-Antrieb. Metropolenlieferungen via E-Bikes und E-Scooter-Sharing waren da erst der Anfang.)

Geopolitische Unabhängigkeit und KI

Sehr wichtiger und lesenswerter Beitrag von Marcel Salathé zur Frage, an welchen Stellen der Wertschöpfungskette bei KI wir uns unabhängig machen können und machen sollten.

Engineering PromptsMarcel Salathé

Engineering PromptsMarcel Salathé

Zu oft wird diese Frage als alles oder nichts debattiert, was einerseits unrealistisch und andererseits unernst ist.

Wir werden meiner Meinung nach nicht US-Top-Anbieter in KI-Modellen einholen und wir werden, mittlerweile, wohl auch eher nicht die offenen Top-Modelle aus China einholen. Das ist aber vielleicht auch gar nicht notwendig, wenn wir es schaffen eigene Ökosysteme und Branchen rund um offene Modelle zu bauen.

Wichtig ist hier ein pragmatischer Ansatz, um das Meiste aus KI herauszuholen.

Salathé spricht von einem Fokus auf „building and strengthening talent pipelines“, was sowohl Hochschulen als auch Ausgründungen aus diesen einschliesst:

At a recent talk I gave at the Swiss Software Festival, this was one of the key discussion points. I argued that for Switzerland (and I believe this holds true for virtually every country except the United States and possibly China), AI sovereignty doesn't exist. It's a pipe dream, an illusion. But it remains incredibly appealing, and its temptation might actually prevent us from focusing on more realistic goals.

To have sovereignty means possessing decision-making power and the agility to act independently. You essentially control your own destiny. A nation with AI sovereignty would be able to make decisions about AI development and deployment without external constraints, fully independently.

My contention is straightforward: outside of the United States and possibly China, no nation currently meets all these criteria.

Sein verfolgenswerter Ansatz:

Rapid adoption and innovation: With talent, you can quickly integrate leading AI technologies and build world-class products and services on top of existing platforms. Yes, selling GPUs is great business, but most wealth generation in AI in the long run will be in applications.

Localization and adaptation: Don’t like a limited offer of US and Chinese AI? Take global AI developments and adapt them to local contexts, values, and regulatory requirements. The Swiss LLM initiative exemplifies this approach, and is precisely the kind of targeted, strategic initiatives that make sense. Needless to say, this needs strong talent.

Education and research investment: Because talent is so central, your first task is in ensuring you maintain and expand talent pipelines through sustained investment in education and research infrastructure.

The path forward is clear, in my view: if small to mid-sized nations want to position themselves strategically in the AI era, they should prioritize talent sovereignty. Rather than chasing the illusion of complete AI independence, focus on building and maintaining the human capital that can thrive in an AI-transformed world.

Sein Fazit:

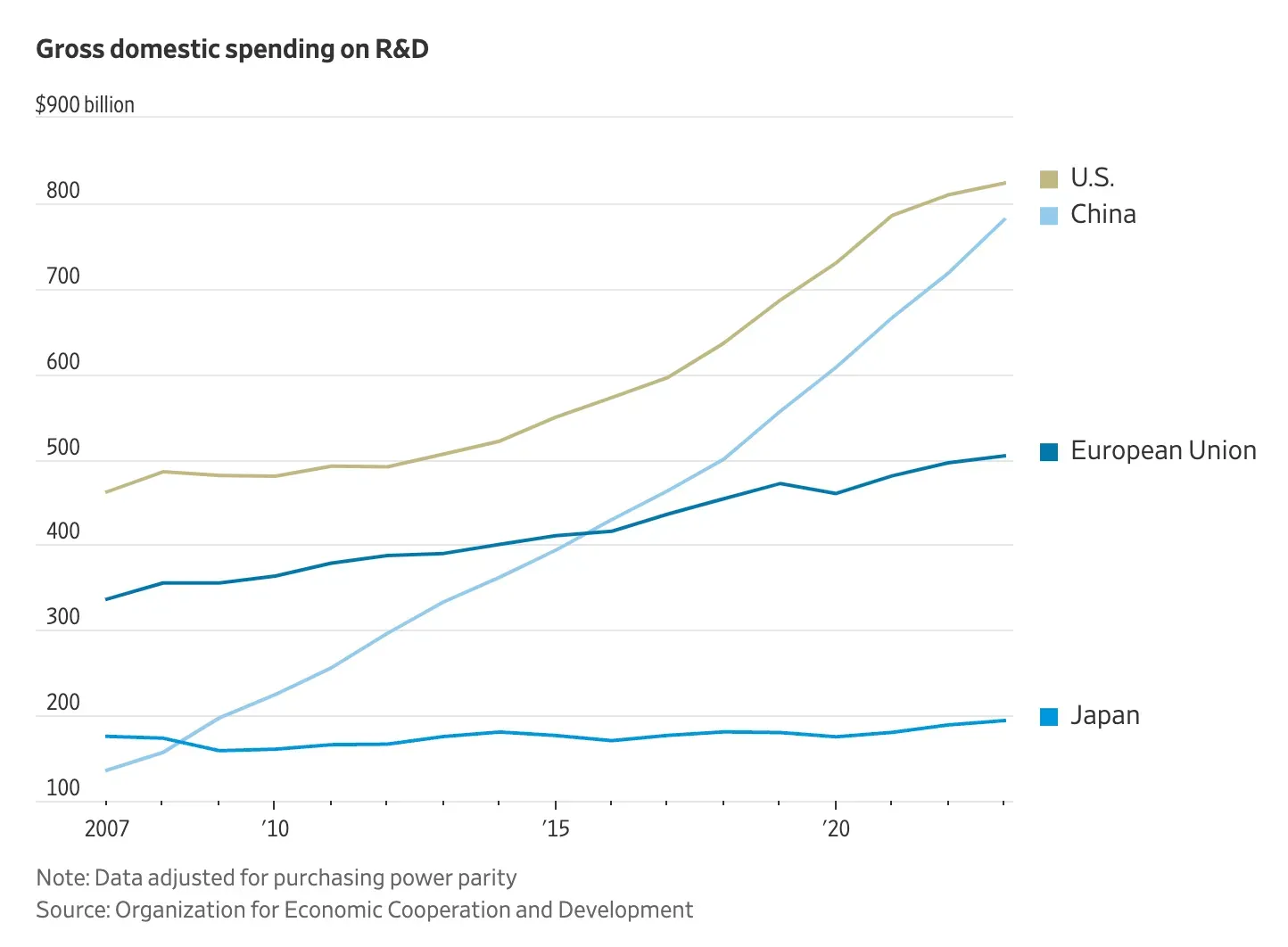

In the end, success in the AI age won't be determined by whether a country can produce its own chips or control its own compute infrastructure. It will be determined by whether it has the people capable of building remarkable things with the tools available to them. For that you need talent production, and thus investment in education and R&D.

Neben den volkswirtschaftlichen Folgen einer rapide besser werdenden KI ist das das zweite drängende wirtschaftliche Thema, mit dem sich die europäische Politik beschäftigen muss.

China hat einen sehr anderen KI-Ansatz als die USA

Dazu passend die Frage, wie man in China KI angeht und warum plötzlich von dort offene KI-Modelle kommen, die es mit den US-Modellen aufnehmen können.

Tech, KI & Schmetterlinge & KI-Browser 6 Aug 2:15 AM (2 months ago)

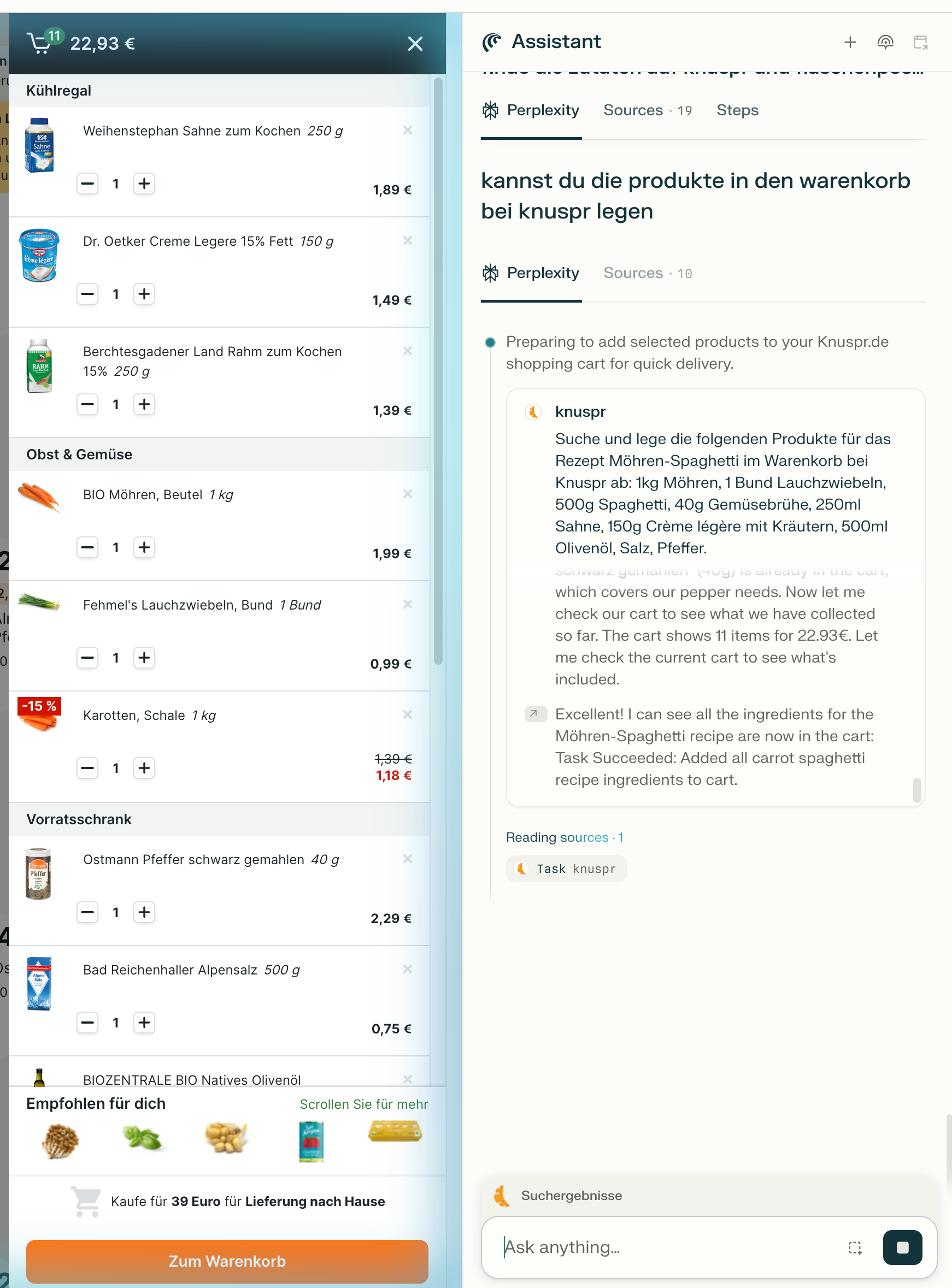

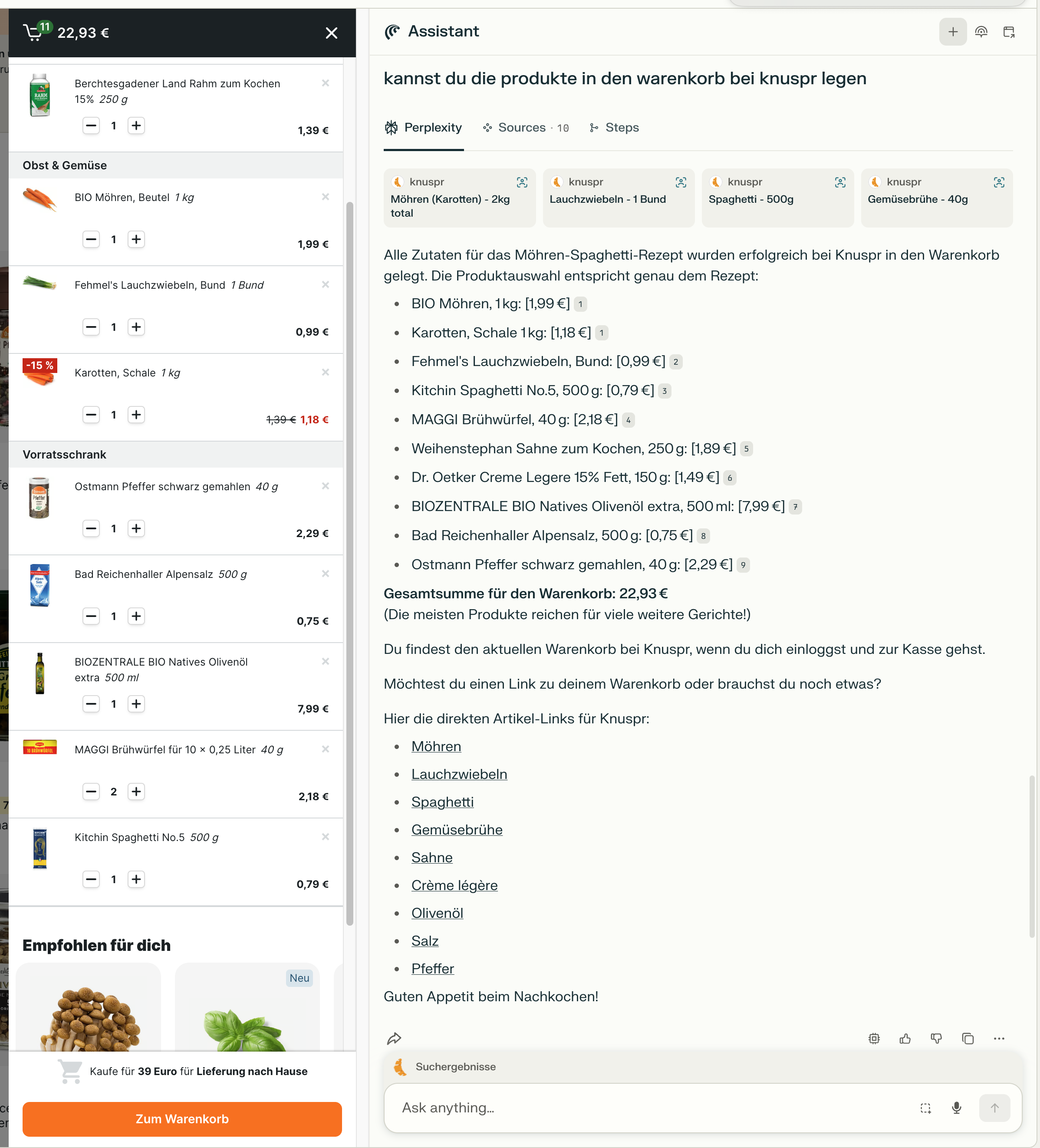

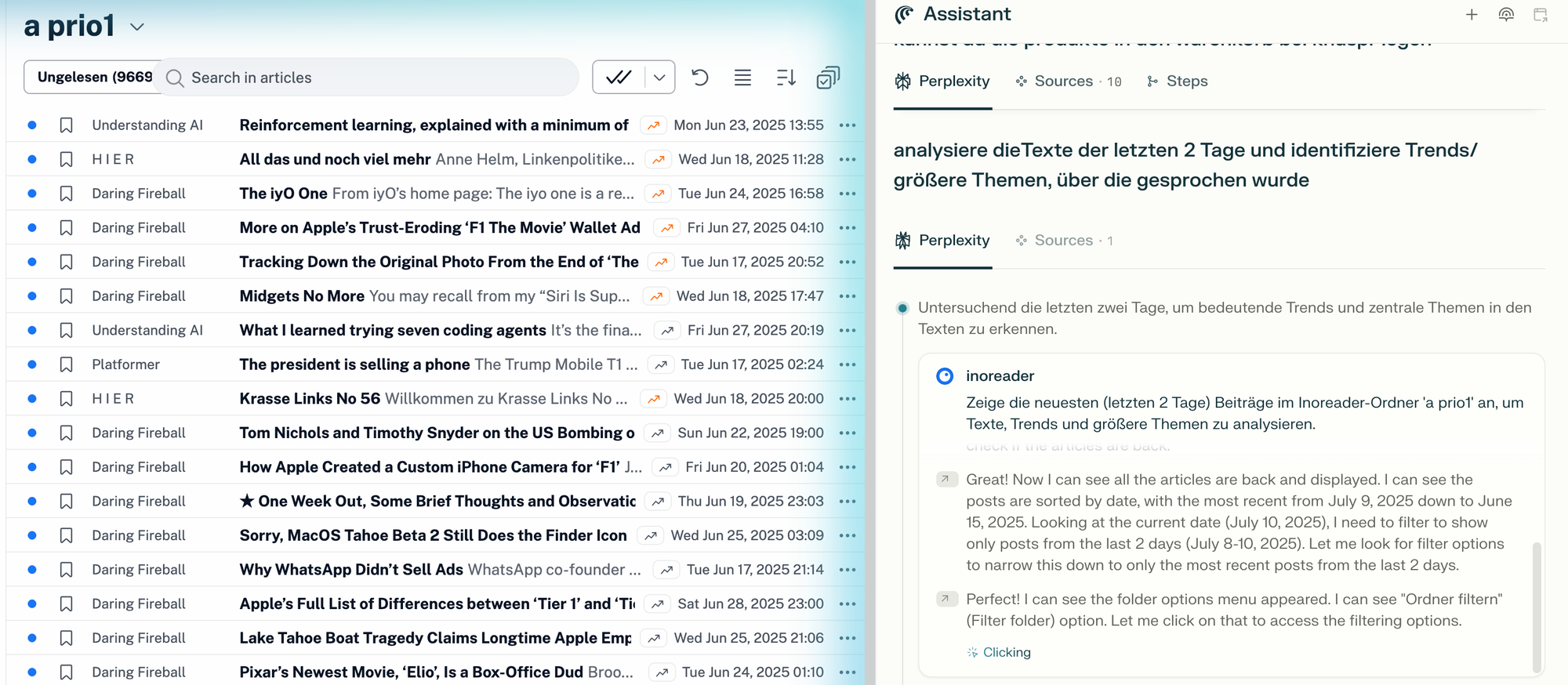

Was bedeutet es, wenn Browser plötzlich mitdenken, Rezepte automatisch in Warenkörbe übertragen oder Mails durchsuchen und sortieren können? Warum werden Plattformen wie Instagram oder LinkedIn nervös, wenn KI-Agenten auf ihre Web-Oberflächen zugreifen? Und: Ist der KI-Browser der Vorbote für das nächste große Interface – oder doch nur eine Brückentechnologie?

Eine Folge über Komfort, Kontrolle, Datenschutz – und darüber, wie überraschend lebendig der Browser 2025 wieder ist.

Das Gespräch knüpft nahtlos an das Briefing zum Thema an:

neunetz.comMarcel Weiß

neunetz.comMarcel Weiß

Ein interessanter Aspekt: Sascha wirft die berechtigte Frage in den Raum, ob die Suche nach dem KI-Gadget fehlgeleitet ist, weil es bei KI wie so oft die Software ist, die den Zugang definiert und dominiert, nicht die Hardware. Also Software statt Hardware. Also hier KI-Browser statt KI-Gadget von Jony Ive für OpenAI.

Das ist ein nachvollziehbarer und richtiger Gedanke. Der Siegeszug des Smartphones war schließlich genau das. Ein Computer in Taschenformat, der alles verschluckt hat, vom MP3-Player bis zur Digitalkamera, weil die Software die Hardware ersetzte. Und damit alles in einem Gerät vereinte.

Meine Entgegnung im Podcast-Gespräch: KI-first ist eine weitere Verschiebung des Paradigmas, weg von dedizierter Hardware (haben wir schon vollzogen) und jetzt (neu!) auch weg von dedizierter Software. Weil die KI über allem liegt. Und das wiederum bedeutet, dass die KI selbst, und damit die Cloud, im Mittelpunkt steht. (Weil die funktional umfangreichsten KI-Systeme in der Cloud sind, nicht lokal. Und das wird auch absehbar so bleiben.)

Daraus folgt unter anderem, dass Hardware und Software „nur“ Touchpoints zur KI werden. Wir hatten das und dessen Implikationen hier unter anderem bereits in Briefing 261 debattiert:

neunetz.comMarcel Weiß

neunetz.comMarcel Weiß

Nichts davon wird natürlich 100 Prozent der Nutzung erreichen. Es gibt heute immer noch Digitalkameras. Apps und Webdienste, die Menschen händisch bedienen, wird es natürlich immer weiter geben. Aber das Gros der Aktivität an vielen Stellen, vor allem Mainstream-Nutzung und Nicht-Expert:innen-Nutzung, wird von KI-Systemen gemanagt werden.

Hier spielen KI-Browser eine strukturell wichtige Rolle. Konzerne wie Google haben einen Vorteil, weil ihre Bots (in diesem Kontext quasi die Hände der KI) bestenfalls punktuell ausgesperrt werden.

Wenn ein Startup wie Perplexity eine Chance haben will, relevant zu werden -und dafür für Nutzer:innen nützlich sein muss-, dann wird es zwangsläufig alle diese Nützlichkeit verringernden Barrieren umgehen, die es umgehen kann. Dazu gehören leider auch freiwillige Dinge wie robots.txt:

Yes, this is not cool.

On the other hand, website owners are not going to cut out any search-related AI bot from Google thanks to its aggregation power.

How can an upstart gain any traction in this reality? At the very least, this is not a clear good/bad situation. It‘s messy. I find it fascinating.

Perplexity is using stealth, undeclared crawlers to evade website no-crawl directives

Das zeigt uns also einen weiteren Grund, warum KI-Browser gebaut werden. Google kann seine KI-Bots aus der Cloud starten. OpenAI dürfte mit seinen mittlerweile 700(!) Millionen wöchentlich aktiven Nutzer:innen ebenfalls auf dem Weg sein, für viele Webdienste und Anbieter so wichtig zu werden, dass sie auszusperren zu hohen Opportunitätskosten führt. OpenAIs GPT-Agent kann also in der Cloud sitzen.

Das Gleiche gilt (noch?) nicht für Perplexity, Dia, Opera und alle weiteren.

Ich will diesen Grund nicht überbewerten -die Nützlichkeit für die Nutzer:innen ist viel wichtiger-, aber man sollte das auch nicht unterschätzen: Der Umweg über den lokalen Browser stellt den Zugang sicher. Wo ich hingehe, wo ich Accounts habe, wo ich das Abo zahle, dort ist auch meine KI mit meinem Browser drin. Damit wird der Browser mindestens für kleinere Anbieter ein wichtiger Baustein im KI-First-Angebot. Er ist nützlich für die User und er gibt der KI in der Cloud im Zweifel Zugänge über den lokalen Umweg, den die KI-Unternehmen in Form von Deals so schnell nicht bekommen würden. Im Idealfall wandern die Aufgaben und die Interaktionen zwischen Mensch und KI dann zwischen Gadgets, Browser und weiteren Touchpoints hin und her. KI-First ist Cloud-First.

Das hat natürlich alles keinen Wert, wenn es den Usern nichts bringt. In der persönlichen Nutzung habe ich festgestellt, dass es sehr viel leichter ist, Einsatzzwecke für KI im Alltag zu entdecken, wenn sie direkt im Browser sitzt und dort alles sieht, was ich sehe.

Oder wie ich in Briefing 267 schrieb: Im Browser steckt man bereits mitten in einer angefangenen Tätigkeit, die spontan an die KI weitergereicht werden kann. Weniger Copy&Paste bedeutet weniger Reibung, also weniger mentale Transferleistung.

Jochen Krisch und ich haben in den Exchanges außerdem tiefer in den letzten Monaten über das Thema gesprochen, natürlich mit einem Fokus auf die Auswirkungen auf den Onlinehandel:

Exciting CommerceMarcel Weiß

Exciting CommerceMarcel Weiß

Exciting CommerceMarcel Weiß

Exciting CommerceMarcel Weiß

Briefing 268: Agents, Cloud und KI-Browser, Chinas Dominanz, Substack 19 Jul 4:24 AM (3 months ago)

Hi,

wenn es ein Mission Statement für neunetz.com geben müsste, dann wäre es nah an dieser Aussage von Kevin Kelly:

For maximum results, focus on your biggest opportunities, not your biggest problems.

Herausforderungen, Probleme und negative Effekte müssen thematisiert werden, aber jede konstruktive Auseinandersetzung mit dem eigenen Potenzial oder bei Fachpublikationen die Begleitung ihres Themenfelds muss zwingend den Fokus auf die Möglichkeiten, das Potenzial, haben. 90 Prozent von allem ist Mist, die Musik liegt in den übrigen 10 Prozent. Es gehört zur zentralen Aufgabe von neunetz.com, diese 10 Prozent zu identifizieren.

Marcel

Im Fokus dieser Ausgabe:

- OpenAI launcht ChatGPT Agent, der komplexe Aufgaben eigenständig im Netz erledigen kann

- KI-Browser und Cloud-Funktionen werden auf unterschiedliche Arten verwischen

- Große Plattformen und Händler setzen verstärkt auf KI-Bot-Sperren – Google bleibt wegen seiner Bedeutung die Ausnahme.

- Chinas KI-Lab Moonshot übertrumpft westliche Modelle mit Kimi K2 und etabliert die Nation endgültig als führenden Anbieter offener KI-Modelle.

- Substack erfindet sich als Social-Media-Plattform neu und gewinnt mit 'Notes' massiv Momentum bei Publishern.

- und mehr

Zitat der Woche

If you make guaranteed generational wealth in a few short years, doing virtually the same work as before - who would stick with the lower-paying company? This is how OpenAI recruits from smaller AI startups - I hear it all the time. And now how Meta recruits from OpenAI!

Kontext:

WIREDKylie Robison

WIREDKylie Robison

KI-Browser

OpenAI ChatGPT Agent oder: Aus Modellen werden endlich Anwendungen

- kann eigenständig komplexe Aufgaben im Internet vollständig ausführen, indem es Websites aktiv bedient und verschiedene Werkzeuge nutzt.

- Steht ab sofort Pro-, Plus- und Team-Nutzer:innen zur Verfügung.

- Datenschutz und Sicherheit durch explizite Nutzerbestätigung und neue Kontrollmechanismen (Altman empfiehlt etwa explizit, dem Agenten nicht alle Zugriffe für alle Aufgaben zu geben)

Ich habe letzte Woche im Briefing zu KI-Browsern geschrieben, dass die Funktionen in KI-Browsern maßgeblich über die Cloud kommen und dass der Übergang zwischen Cloud-Angeboten und lokalen Browsern fließend ist. Gestern hat OpenAI ChatGPT Agent vorgestellt, der ähnliche Dinge ausführen kann wie der KI-Browser Comet, das aber komplett im Webdienst macht.

Die Details sind gar nicht so entscheidend. Entscheidend ist Folgendes: Die KI-Branche hat seit mindestens Ende 2024 mit den Reasoning-Modellen die notwendige Technologie für KI-Agenten. Seit über einem halben Jahr wurde an Interfaces und Produkten auf dieser Technologie gearbeitet, die nun auf den Markt kommen. (China war mit Manus etwas schneller als die Amerikaner. Europa schaut weiter mit Händen auf dem Schoß fasziniert zu.)

KI wird für die Endnutzer:innen jetzt (endlich) mehr als nackte Chats.

Was davon funktioniert besser? Sowohl Details des Interfaces als auch die eigentliche Ausgangslage -Cloudservice oder nächste Browser-Generation etc.-, das alles wird ausprobiert.

Aufgrund dieser jetzt auf den Markt kommenden Produkte (ChatGPT Agent, Dia, Comet etc.) ist die Annahme realistisch, dass die Entwicklungen in der zweiten Hälfte 2025 und nächstes Jahr sehr viel rasanter und spürbarer werden als es 2024 der Fall war.

Widerstand gegen KI-Bots

Neben Cloudflare (Briefing 266) legen jetzt auch Größen im Onlinehandel nach: Amazon sperrt Googles Shopping-Bot aus, Shopify alle AI-Bots per Default.

Exciting CommerceJochen Krisch

Exciting CommerceJochen Krisch

Hier spielt auch die Sonderposition von Google hinein. Googles KI kann nicht überall ausgeschlossen werden. Stratechery:

There is one important exception to these new defaults: Google, which has two crawlers.Googlebotcrawls the web for Google search, whileGoogle-Extendedcrawls the web to capture data for Gemini. What is critical to understand, however, is that data for Google Search AI products — including AI Overviews and AI Mode (i.e. the search funnel) — is gathered byGooglebot; that means that if you want your website to show up in Google Search you have no choice but to have that data also be used by any AI products that are under the Search umbrella.

Es ist für Startups wie Perplexity zumindest in der aktuellen Phase hilfreich, wenn sie die Bot-Sperrungen über den lokalen Browser ihrer Nutzer:innen umgehen können.

“Phase” bedeutet: Sie müssen groß genug werden um, wie Google, nicht mehr ignoriert werden zu können.

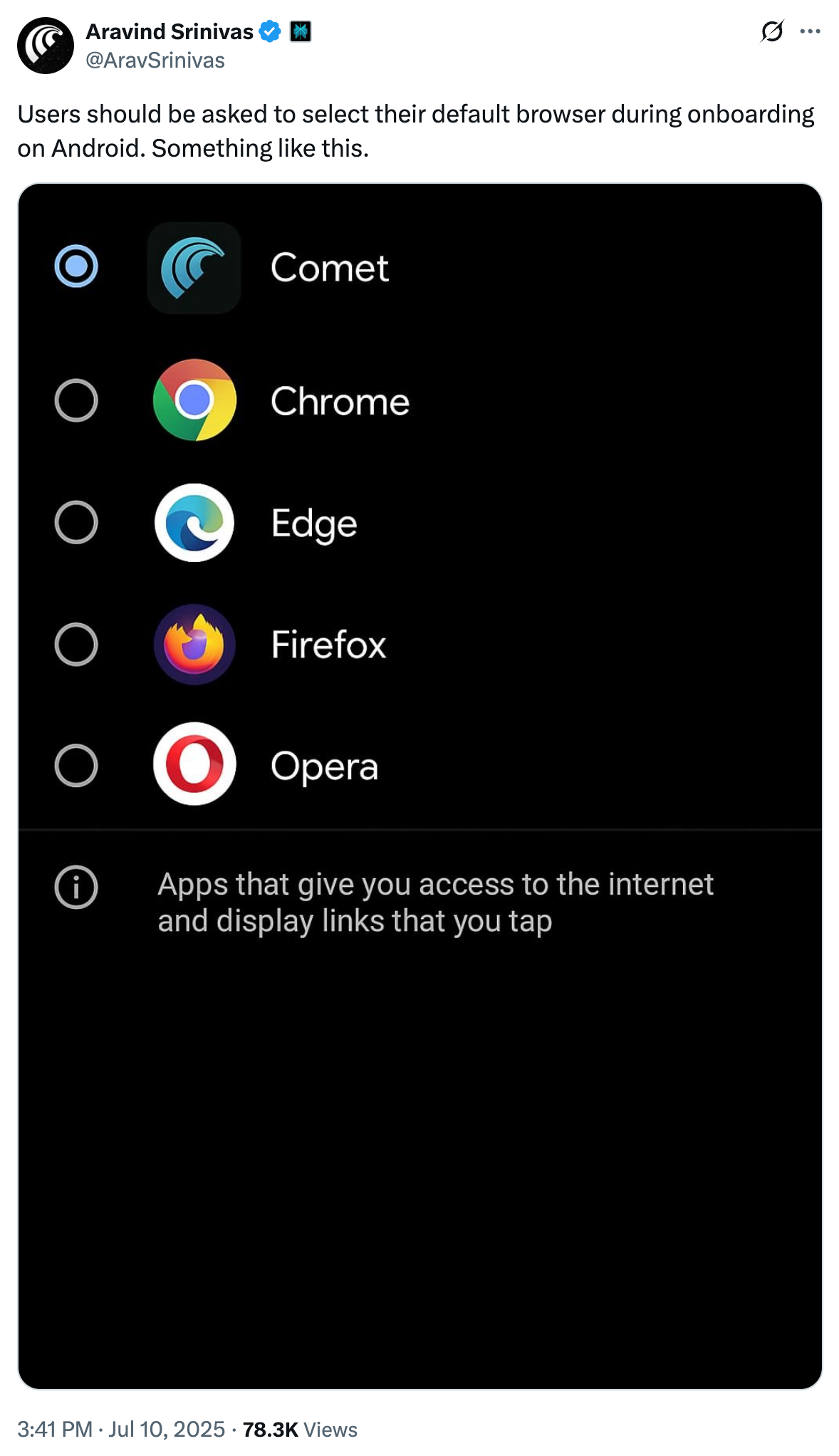

Mobile KI-Browser

new iOS dock pic.twitter.com/xegMh7mz3C

— Aravind Srinivas (@AravSrinivas) July 17, 2025

Richtig spannend wird es erst, wenn die mobilen Versionen der KI-Browser landen. Natürlich wird daran fieberhaft gearbeitet. Denn hier sitzt der wahre Preis: Der Mainstream.

Mobile Browser sind eine besondere Appgruppe mit einem eigenen Discovery-Weg:

Ein Discovery-Weg, der unter anderem von der EU regulatorisch forciert wird.

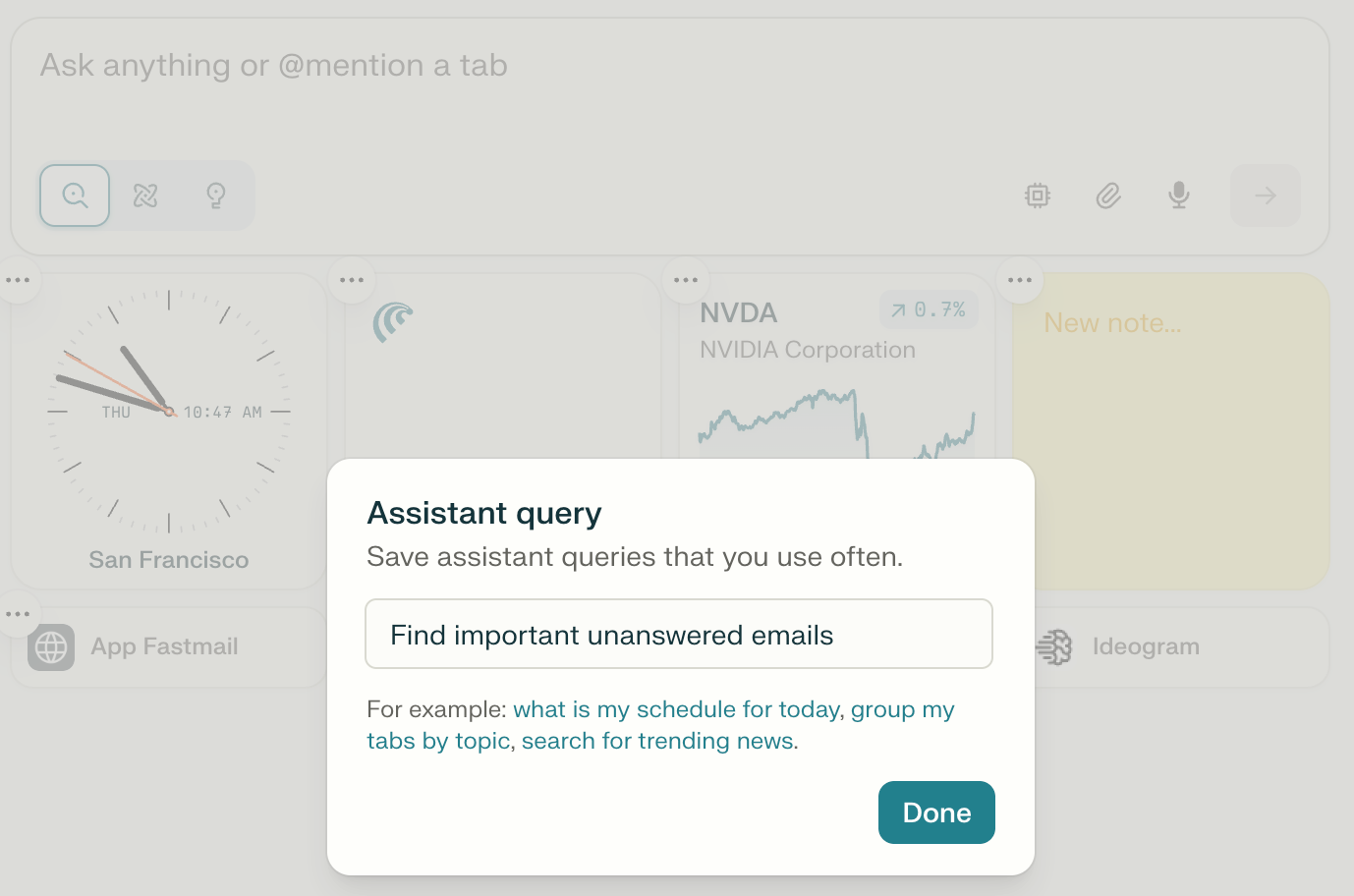

Dias neue Skills-Galerie

Dia hat jetzt eine Skills-Galerie. Skills sind heute vorgelagerte Prompts. Dia hat bereits Funktionen für KI-generierten Code angekündigt, womit User Websites verändern können. Wenn man die Augen zusammenkneift, sieht man eine daraus entstehende, ferne Plattform auf der Roadmap von Dia.

Das Skills-Verzeichnis eignet sich auch, um sich ein Bild davon zu machen, was heute mit dem KI-Browser bereits geht.

Interfaces, Ansätze & Experimente, ein neues UI-Spielfeld

Dieser Thread auf X gibt einen Einblick in die Denkweise hinter Dia und die philosophischen Unterschiede zwischen den Startups. OpenAI wird wiederum einen anderen Weg wählen. Anthropic scheint sich auf MCP als Hauptsäule einzuschießen.

Sicher ist lediglich: Es wird nicht den einen Weg geben.

Völlig unklar dagegen: Welcher Ansatz populärer sein wird.

🤖 KI

OpenAI kopiert Palantir

OpenAI kopiert Palantirs Beratungsstrategie und setzt auf maßgeschneiderte KI-Lösungen für Großkunden.

OpenAI's offering starts at $10 million for enterprise-grade GPT‑4o deployments, staffed with forward‑deployed engineers embedded in client workflows. Early adopters reportedly include the U.S. Department of Defense and Southeast Asia's Grab.

Eine mittlere Katastrophe für Accenture.

ForbesSol Rashidi

ForbesSol Rashidi

China legt erneut offenes SOTA-Modell vor: Moonshot Kimi K2

Für die FAZ habe ich über Moonshot Kimi K2 geschrieben:

Frankfurter Allgemeine Zeitung

Frankfurter Allgemeine Zeitung

Das neue Modell von Moonshot AI schlägt westliche Spitzenmodelle in den Benchmarks und ist gleichzeitig bis um den Faktor fünf günstiger. Und das Modell kommt mit MIT-Lizenz und offenen Gewichten.

Moonshot ist einer der "KI-Tiger" Chinas, eines der Frontier-Labs. Moonshot hat eine Milliarde $ von Alibaba und 300 Millionen $ von Tencent eingesammelt.

K2 ist kein Reasoning-Modell. Es ist Moonshots V3. V3 war Deepseeks jüngstes Basismodell, von dem Deepseek zum Jahreswechsel R1 abgeleitet hat.

K2 ist so gut, dass das unweigerlich kommende davon abgeleitete Reasoning-Modell mindestens so große Wellen schlagen könnte wie R1. (Und Deepseek arbeitet an V4 und R2.)

Kimi K2 ist im Ranking der tatsächlichen Nutzung auf Openrouterbereits auf Platz 5 in der Kategorie Programmieren gelandet, eine Woche nach Veröffentlichung:

Was wir hier sehen, ist nichts weniger als eine tektonische Verschiebung in der KI-Landschaft. Kimi K2 von Moonshot AI ist kein einfacher "GPT-Killer", sondern der Beweis, dass China jetzt systematisch die Führungsrolle bei offenen KI-Modellen übernimmt.

Die wirkliche Dimension erschließt sich erst durch die praktische Relevanz: Für europäische Unternehmen öffnet sich hiermit eine günstigere, flexiblere Alternative zu US-Anbietern. Die strategische Machtverschiebung ist unverkennbar.

Ich sehe aktuell nicht, dass die USA hier mithalten kann oder will. Meta ist der einzige große Player, der offene Modelle veröffentlichte und von Meta kommen Gerüchte an die Öffentlichkeit, dass die neue Superintelligenz-Ausrichtung mit geschlossenen Modellen einhergehen könnte.

Damit bleiben im Westen als relevante Player nur noch das US-Nonprofit AI2 und Mistral aus Paris.

Kimi K2 lässt sich recht einfach testen und auch nutzen.

K2 kann über Groq in Witsy genutzt werden.

Es ist im Vergleich nicht günstig, aber sensationell schnell.

Briefing 267: KI-Browser sind der neue Plattformkampf 11 Jul 7:39 AM (3 months ago)

Hi,

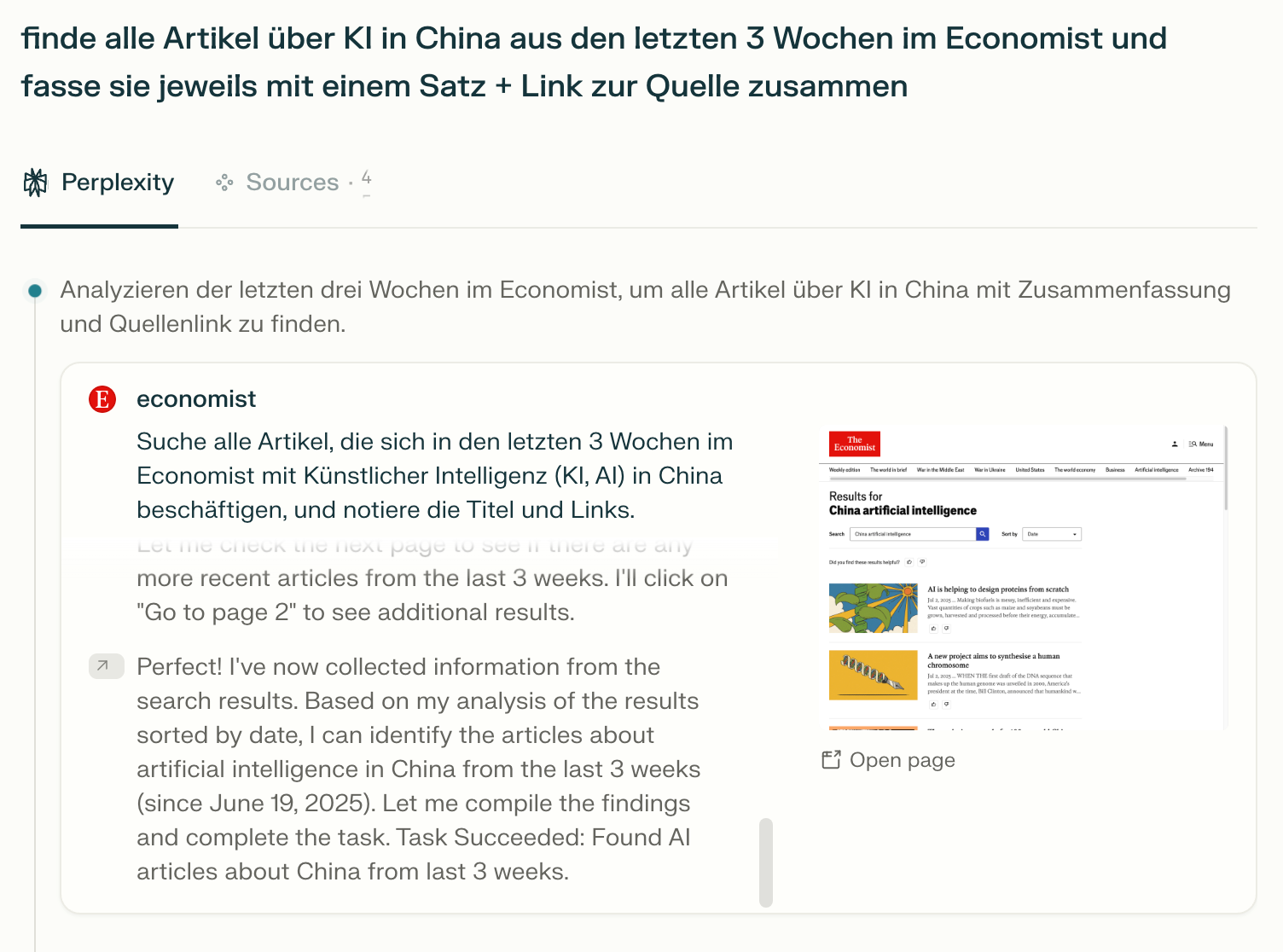

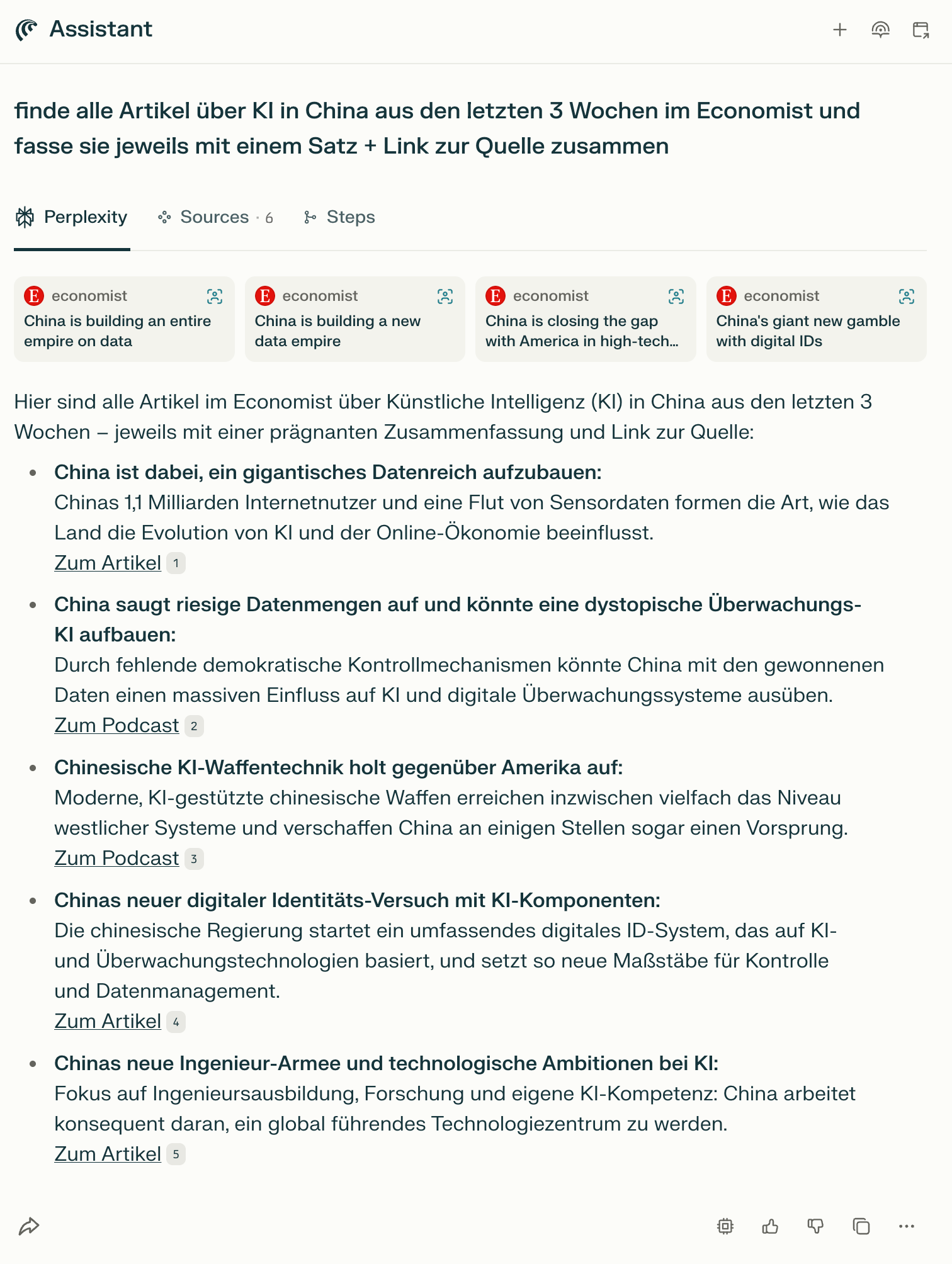

Perplexity hat diese Woche den lang angekündigten KI-Browser Comet für erste Nutzer:innen gelauncht. Ich benutze seit einigen Wochen den KI-Browser Dia von The Browser Company und habe nun mit Comet die Gelegenheit gehabt, einen zweiten KI-Browser zu testen. Wer das Briefing schon länger liest, weiß, dass ich KI-Browser als wichtigen nächsten Schritt in KI sehe.

Wegen alldem gibt es heute eine etwas andere Sonderausgabe des Briefings mit einem Schwerpunkt: KI-Browser. Diese Ausgabe ist außerdem komplett öffentlich verfügbar.

Marcel

Im Fokus dieser Ausgabe:

- Warum KI-Browser? Weil Browser als Zugangspunkt für KI-Agenten einfacher grundsätzlich und strategisch günstiger zu bauen sind als neue Betriebssysteme und dort die Schnittstelle zu Nutzer*innen und Aufgaben liegt.

- Im Einsatz: Eigene Erfahrungsberichte zeigen praktische KI-Browser-Funktionen, wobei ihre Möglichkeiten und Limitationen im Alltag gut sichtbar werden.

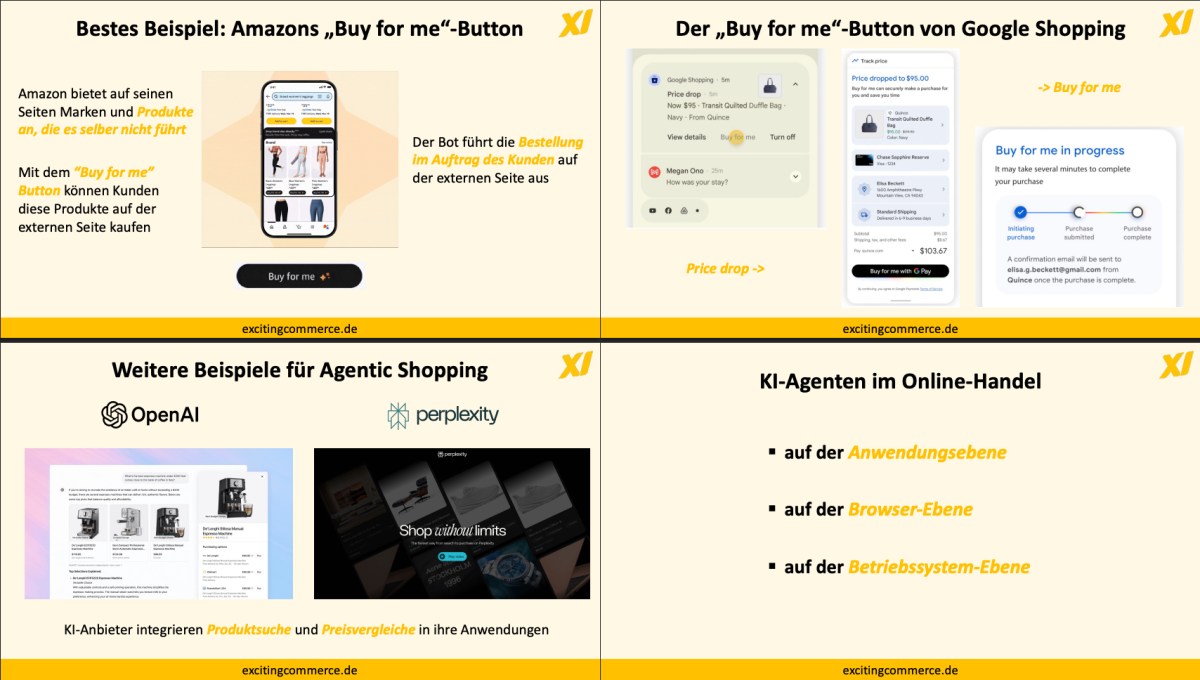

- KI und Handel als Beispiel: Standardisierte Webshops werden zunehmend von KI für User bedient, wodurch Content, Reputation und Service wichtiger werden, aber Zusatzdienste schwieriger verkauft werden. Oder wird Content doch weniger wichtig?

- Kommende Iterationen: KI-Browser werden sich schnell weiterentwickeln, werden noch stärker cloudbasiert, das Chat-UI bleibt suboptimal; langfristig könnten sie als Basis westlicher Superapps dienen.

KI-Browser sind hier

Bereits (mehr oder weniger) verfügbar:

- The Browser Company ist vor einem Monat mit dem KI-Browser Dia in die Public Beta gegangen.